基於人類回饋的強化學習(RLHF)成為2025年AI領域大模型訓練和智慧升級中不可或缺的核心技術。文章全面梳理RLHF的基礎原理、與傳統RL的差異、關鍵訓練流程及主流應用工具,深入剖析資料瓶頸、獎勵模型偏差、算力門檻等技術挑戰,並著重跟進HybridFlow平行訓練、COBRA共識機制、個人化RLHF等2025年領域最新突破。展望未來,RLHF正驅動AI朝向更安全、可控與多元價值對齊轉型,是AI進化「懂你」的必經之路。

RLHF基礎知識與技術原理

RLHF的定義與核心流程

RLHF(基於人類回饋的強化學習)融合了人類評估機制與強化學習演算法,實現AI決策對人類期望的高度對齊。它包括預訓練、獎勵模型訓練、強化學習最佳化等典型環節,就是推動ChatGPT、Gemini等生成式AI大模型落地的關鍵驅動力。

RLHF與傳統強化學習差異點

| 對比維度 | 傳統強化學習(RL) | RLHF |

|---|---|---|

| 獎勵訊號 | 環境設定、自動數值 | 來自人類評分/偏好 |

| 目標 | 最大化環境獎勵 | 最大化“人類主觀偏好” |

| 對齊能力 | 難以捕捉人類複雜需求 | 可對齊人類價值觀 |

| 容易欺騙性 | 獎勵黑客問題嚴重 | 加強監理可降風險 |

RLHF有效彌補了傳統RL難對齊人類複雜偏好的短板,推動AI更貼合實際人類意圖。

RLHF在AI系統與大模型訓練的應用

典型訓練流程與應用平台

- 人類標註與採集:高品質人工評分輸出數據。

- 獎勵模型構建:排序、成對比較訓練獎勵網。

- RL優化:用PPO/DPO等引導人偏好。

主流RLHF平台包含:

- OpenAI ChatGPT(強對齊落地)

- DeepSeek(冷啟動與高效訓練)

- Perle.ai(自動化標註)

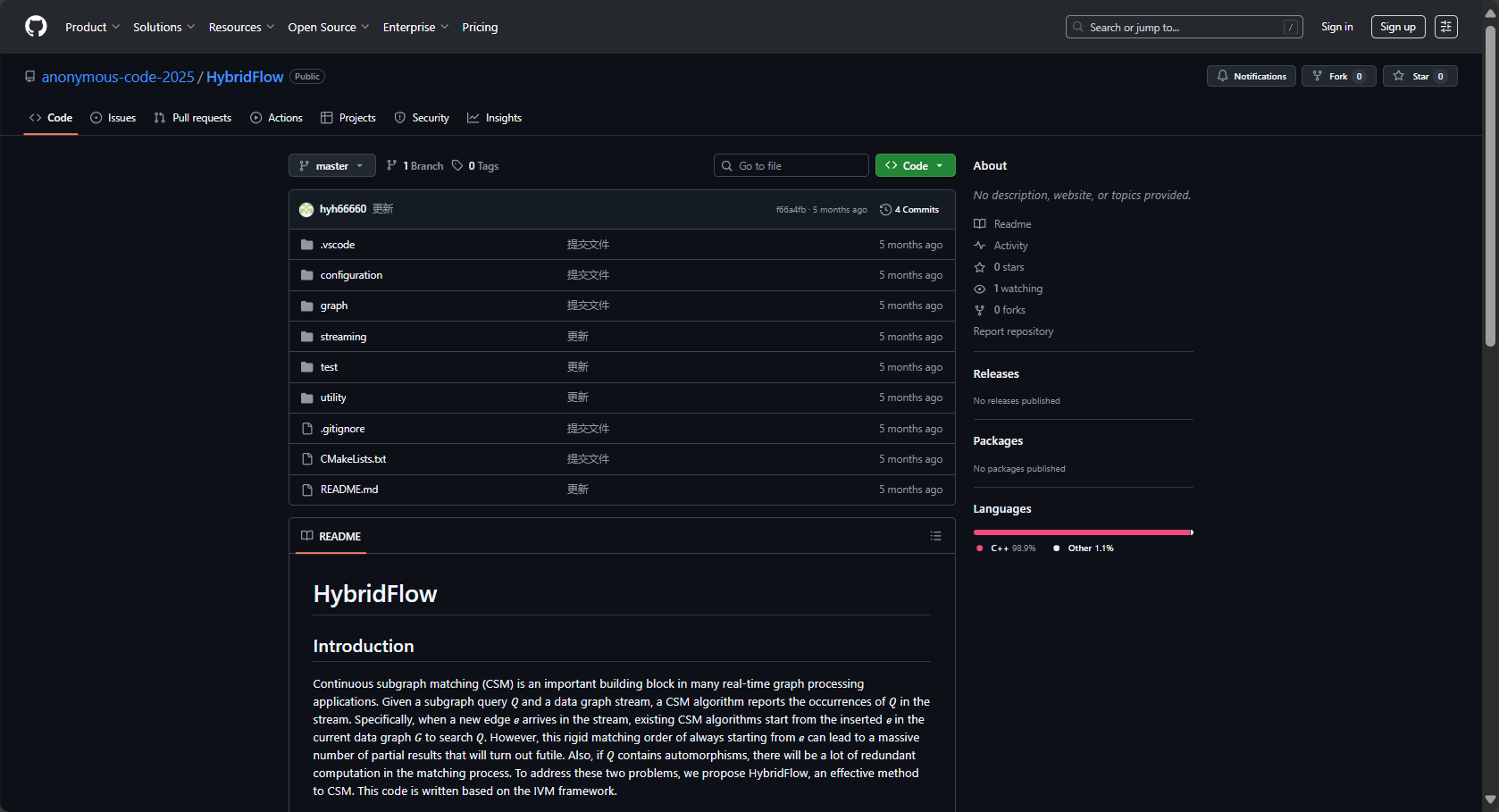

- HybridFlow(大規模平行訓練)

技術挑戰分析

- 高品質標註數據稀缺:人工成本高、主觀因素多、易帶偏見。

- 獎勵駭客與基礎能力退化現象:模型優化偏離實際期望。

- 海量算力與長週期訓練:新創團隊門檻高。

詳解見CSDN前沿專欄。

2025年RLHF關鍵技術突破

| 研究方向 | 關鍵方法 | 應用成效 |

|---|---|---|

| 獎勵模型優化 | 比較訓練、偏好損失 | 加快訓練收斂、提升有效性 |

| 高平行訓練框架 | HybridFlow/管線解耦 | 吞吐量提升1.5-20倍 |

| COBRA共識機制 | 動態聚合過濾異常 | 獎勵準確度提升30~40% |

| 分段獎勵機制 | 片段切分+歸一化 | 優化速度與連貫性大幅提升 |

| 個人化訓練 | Shared LoRA低秩適應 | 垂直場景個性化表現優異 |

| 合成數據結合專家標註 | 自動工具+人工抽查 | 資料保真提升60% |

詳細改進方向解讀

- 獎勵模型高方差訓練帶來更快最佳化收斂,策略演算法更穩健。

- HybridFlow以細粒度流水線並行極大提升訓練效率。

- COBRA共識有效防止惡意與異常回饋污染模型獎勵。

- 片段獎勵與歸一化讓文字持續優化提升。

- Shared LoRA適配用戶偏好,微樣本場景效果提升。

- 合成數據+專家標註,顯著緩解資料瓶頸。

RLHF技術融合與2025年發展趨勢

| 改進方向 | 技術點 | 代表案例 |

|---|---|---|

| 數據標註 | 半自動化、多元化團隊 | Perle.ai、Synthetic Data |

| 獎勵優化 | 多任務對比、策略改進 | COBRA、HybridFlow |

| 訓練效率 | 流水線/並行/冷啟動 | DeepSeek、RLHFuse |

| 評測體系 | 偏好代理評估 | Stanford PPE |

| 個人化 | Shared LoRA | 醫療/金融/法律等客製化 |

產業應用與未來展望

- 開源社群推動RLHF普及(DeepSeek,RLHFuse等)

- 學術創新突破(普林斯頓、港大混合流訓練等)

- 產業級落地:OpenAI、Google、位元組跳動建構精細鏈路

2025年熱點聚焦於多模態RLHF(視覺、語音)、聯邦隱私權保護RLHF融合,彰顯AI倫理、安全、個人化等多元價值。RLHF已是訓練鏈路中不可或缺的動力引擎。建議關注Coursera RLHF課程及知名開源項目,掌握AI新浪潮!

© 版權聲明

文章版權歸作者所有,未經允許請勿轉載。

相關文章

暫無評論...