Ollama是一站式本地大模型平台,專注於簡易部署、資料私有和多模型相容。 支援Windows、macOS、Linux等多平台,整合Llama3、Mistral、Gemma等30+主流模型,一鍵離線運作、完全在地化,適合個人、企業及研發團隊,免費開源、API开发兼容性强,是构建自主AI应用与保障数据安全的首选方案。

在AI應用快速發展的今天,本地部署大語言模型(LLM)需求日益高漲。 Ollama 作為一款專注於高效、在地化部署的AI工具,已成為全球開發者和資料安全敏感企業廣泛關注和應用的熱門平台。Ollama 官方網站堅持「極簡啟動、在地掌控」的概念,為資料私有化、客製化、可控制的大模型應用帶來了新風向。

Ollama的主要功能

Ollama 不直接提供自有大語言模型,而是搭建了本地大語言模式驅動與管理平台,支援Meta Llama 3、Mistral、Gemma等主流模型,具備多系統相容、低資源消耗、易操作和豐富API生態。

- 多平台快速部署:支援Windows、macOS、Linux、Docker及樹莓派。

- 內建30+主流模型:一鍵切換,支援自訂擴充功能。

- 4GB/8GB顯存即可運行主流模型:CPU、GPU均可調度。

- 豐富開發者生態:REST API、Python/JS SDK,相容於LangChain、RAG等。

- 完全本地化:數據/推理離線私密。

- 可視化介面:與Open WebUI/Chatbox等集成,類ChatGPT體驗。

- 社群活躍,插件豐富:Modelfile模型個人化配置。

功能總覽(表)

| 功能類別 | 說明與舉例 |

|---|---|

| 平台相容 | Win/macOS/Linux/Docker/樹莓派多系統 |

| 模型管理 | 30+模型,Llama 3, Gemma, Mistral等 |

| 資源最佳化 | 4-8GB顯存即可運行,CPU/GPU相容 |

| 資料私有 | 本地運作、資料完全私密 |

| API集成 | REST API/SDK/RAG/Chatbox/Open WebUI |

| GUI前端 | Open WebUI等視覺化,類ChatGPT |

| 開發者生態 | Modelfile、外掛程式、社群活躍 |

Ollama的價格& 方案

Ollama開源免費,所有主流功能和模型呼叫不收取費用。

用戶可在官網自助下載,無商業訂閱或隱藏付費。企業客製化與自架式也無須授權費用,主流模式也多為開源(部分大模型注意版權條款)。

| 使用場景 | 價格 | 備註 |

|---|---|---|

| 軟體下載 | 免費 | 多平台 |

| 主流模型推理 | 免費 | Llama3等 |

| 社區支持 | 免費 | GitHub/Discord |

| 企業自架 | 免費 | 不含專有介面 |

| 客製化/插件 | 免費 | 開源社群 |

如何使用Ollama

極簡安裝和一鍵體驗,適合小白及開發者。

- 硬體準備:8GB內存起,Nvidia顯示卡更佳。

- 安裝:

Windows/macOS下載安裝包,Linux指令:curl -fsSL https://ollama.com/install.sh | sh,或使用Docker。

詳見安裝頁面。 - 拉取/運行模型:

ollama pull llama3ollama run llama3,ollama list查看模型,ollama ps查詢任務。 - 開發整合(API):

curl -X POST http://localhost:11434/api/generate -d '{"model": "llama3", "prompt": "請總結以下內容:"}'' - 可視化介面:推薦用Open WebUI、Chatbox等前端,見整合專案。

| 步驟 | 操作 | 範例命令 |

|---|---|---|

| 安裝 | 系統下載/命令列/Docker | curl -fsSL https://ollama.com/install.sh | sh |

| 拉取模型 | ollama pull | ollama pull llama3 |

| 運行模型 | ollama run | ollama run llama3 |

| 多模型管理 | ollama list/ps/rm | ollama list / ollama ps / ollama rm llama3 |

| API文件 | GitHub/官網 | API文件 |

Ollama的適用人群

- AI研發/程式設計愛好者:本地實驗與演算法創新。

- 中小企業/安全敏感組織:所有資料私有辦公室。

- NLU/多模態研究者:無縫模型切換。

- 個人極客/自用AI:本地知識庫、AI助理。

- 創業/開發團隊:作為AI後端引擎一站整合。

適用場景:企業本地知識庫、文件問答、PDF處理、程式碼助理、圖片辨識、多模態RAG、客服機器人等。

其他亮點與社區生態

主流支援模型一覽表

| 模型名 | 參數規模 | 佔用空間 | 亮點用途 |

|---|---|---|---|

| Llama 3 | 8B+ | 4.7GB+ | 綜合問答、多語言 |

| Mistral | 7B | 4.1GB | 高效能英文優先 |

| Gemma | 1B-27B | 815MB~17GB | 多語言高效率 |

| DeepSeek | 7B+ | 4.7GB+ | 資訊檢索強 |

| LLaVA | 7B | 4.5GB | 圖/多模態 |

| Qwen | 7B+ | 4.3GB+ | 多語言,中文優 |

| Starling | 7B | 4.1GB | 對話微調 |

- Open WebUI/Chatbox/LibreChat等20+第三方GUI,PDF、網頁採集、知識庫等插件生態。

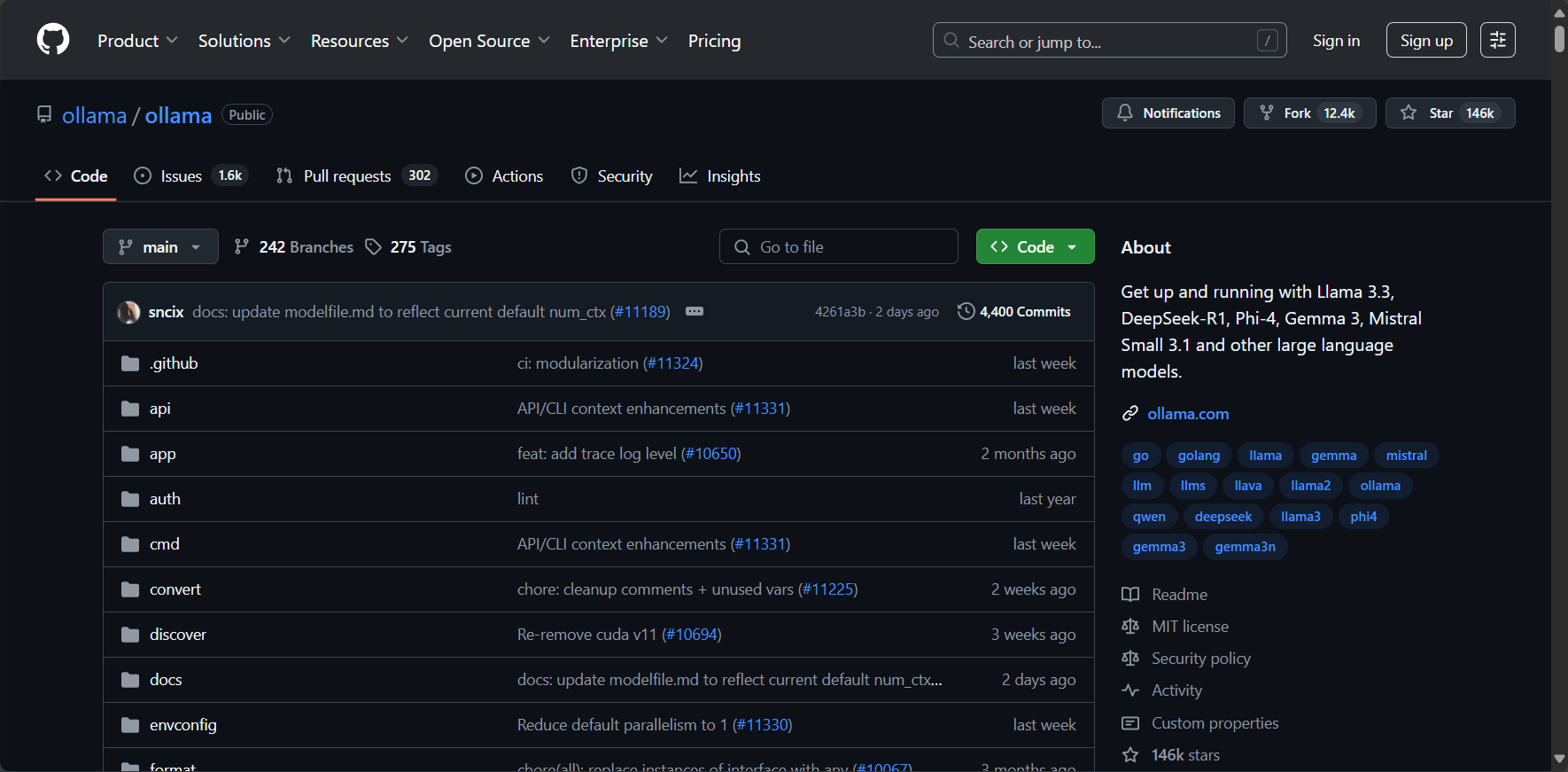

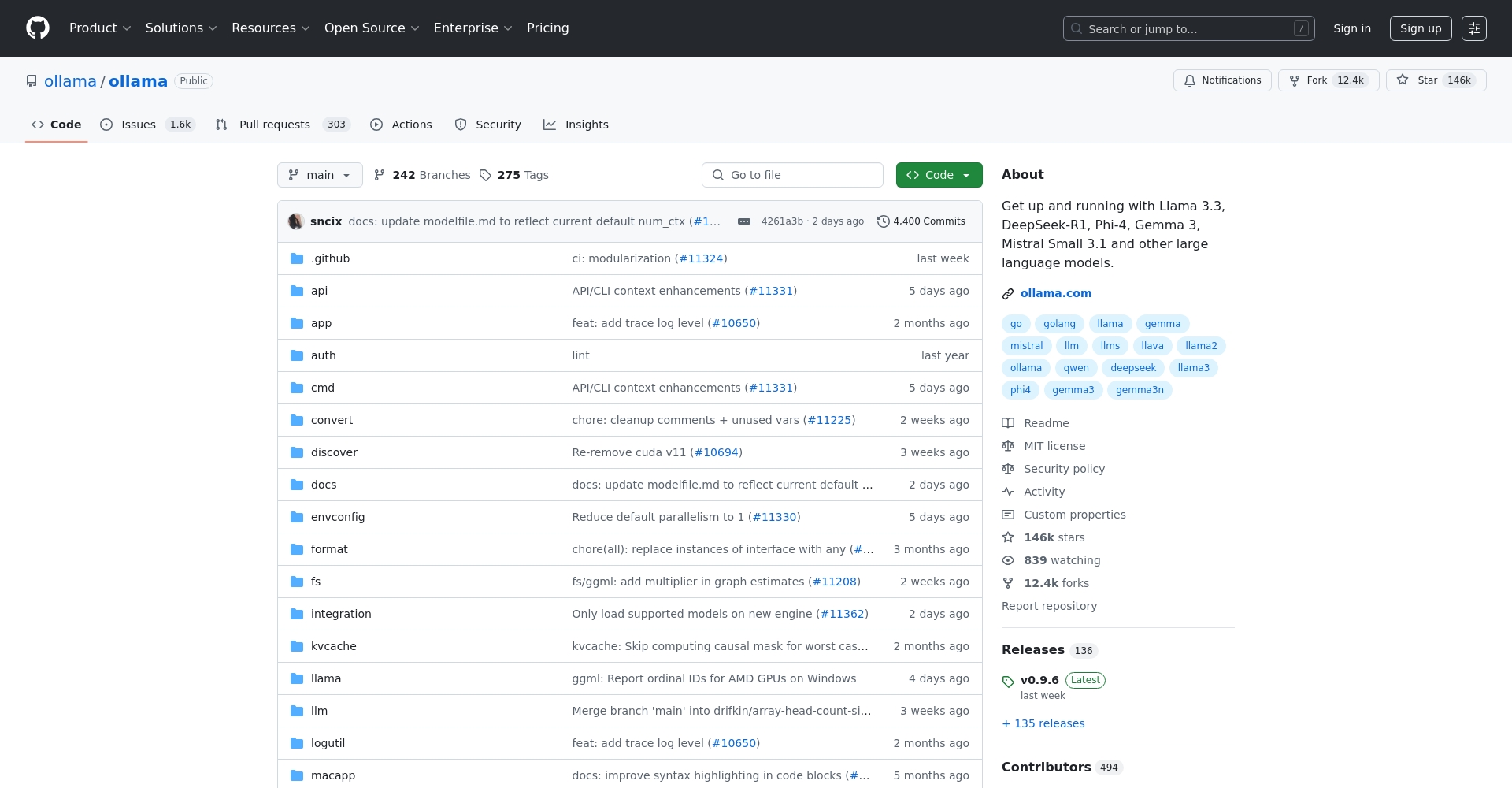

- 14萬Star的GitHub,API/SDK/插件開放,活躍社群支援。

- 相容於LangChain/LlamaIndex/Spring AI等主流框架。

常見問題

Q: Ollama可以「完全本地」運行嗎?

是的,Ollama全程支援離線部署與推理,資料100%不外傳,隱私最佳。

Q:Ollama與ChatGPT有何本質差異?

| 方面 | Ollama | ChatGPT等雲端 |

|---|---|---|

| 部署 | 本地私人離線 | 公有雲端 |

| 資料安全 | 100%本機 | 需上傳雲 |

| 費用 | 免費開源 | 訂閱/按量付費 |

| 自訂 | 強,插件化 | 有限 |

| 模型選擇 | 30+自選 | 官方指定 |

Q:大模型對硬體的需求?

7B機型8GB記憶體+4GB顯存即可,CPU可用,GPU更優;13B模型建議16GB記憶體/8GB顯存,硬碟需預留空間。

| 模型大小 | 記憶體 | 顯存 | 說明 |

|---|---|---|---|

| 7B | 8GB | 4GB | CPU/GPU雙相容 |

| 13B | 16GB | 8GB | 性能更佳 |

| 33/70B | 32GB+ | 16GB+ | 高效能/伺服器 |

結語

隨著AI大模型浪潮推進,Ollama憑藉著極簡本地部署、完全隱私與開放相容,成為全球AI開發者、企業與極客的首選平台。 無論你是個人用戶、企業或創業團隊,Ollama官網都能為你的AI大模型應用和創新提供堅實底座與靈活擴展。關注社區,取得最新插件模型、企業級方案與更多生態動態。

數據統計

數據評估

本站AI 喵導航提供的Ollama都來自網絡,不保證外部鏈接的準確性和完整性,同時,對於該外部鏈接的指向,不由AI 喵導航實際控制,在2025年7月14日下午5:30收錄時,該網頁上的內容,都屬於合規合法,後期網頁的內容如出現,可以直接聯繫網站管理員進行刪除,AI 導航喵不承擔任何責任。

相關導航

Decohere

Capsule

Taskade

PoemGenerator.io

Pixelicious

萬興智演

Hitems