Luminal 是一款新一代AI模型推理加速與資料處理平台,支援主流AI框架模型在各類硬體上的極速部署與高效運作。它透過自動化編譯和無伺服器部署,大幅降低開發者、企業的維運負擔,是AI效率提升領域的創新工具。平台也整合大規模結構化資料與表格的AI清洗處理能力,非常適合科學研究、商業場景使用。

在當今AI技術百花齊放的時代,Luminal 以其精妙的AI模型加速與大型資料處理能力,成為許多開發者與企業關注的焦點。從幫助研究團隊高效部署模型,到企業級海量資料清洗分析,Luminal 正以創新思維重塑AI開發部署流程。本文將以新聞報導形式,深入解析Luminal平台的核心功能、適用場景、使用者操作體驗與價格佈局,並結合官方與市場公開資訊為廣大AI從業人員、開發者、資料工程師呈現立體視角。

Luminal的主要功能

一站式AI模型優化與零運維部署

Luminal 的核心使命是「讓AI模型在任何硬體上都能極速運行」。它透過自主研發的ML編譯器與CUDA核心自動產生技術,將PyTorch等主流架構下的AI模型轉換為針對GPU高度最佳化的程式碼,實現10倍以上推理速度提升,大幅降低了硬體與雲端運算成本。

| 功能類別 | 具體描述 |

|---|---|

| 模型最佳化 | 自動分析模型算子結構,產生最優GPU核心程式碼,不依賴人工手寫優化 |

| 極致加速 | 堪比手寫Flash Attention等高階內核,實現業界頂級推理速度 |

| 自動化部署 | 無伺服器(Serverless)推理,只需上傳權重,即可取得API端點 |

| 智慧冷啟動 | 編譯快取與參數流式加載,顯著降低冷啟動延遲,無資源閒置費用 |

| 自動批次處理 | 動態將請求合併以充分利用GPU算力,實現彈性負載擴展 |

| 平台相容 | 相容主流雲端服務及本地GPU,支援Huggingface、PyTorch框架 |

官方網站提供了詳實的效能基準測試數據,證明其在生產環境對比傳統推理方案優勢顯著。

- 無須手寫CUDA,對開發者極為友好

- 一行程式碼完成PyTorch模型加速部署

- 科研與企業可快速從Notebook推向生產

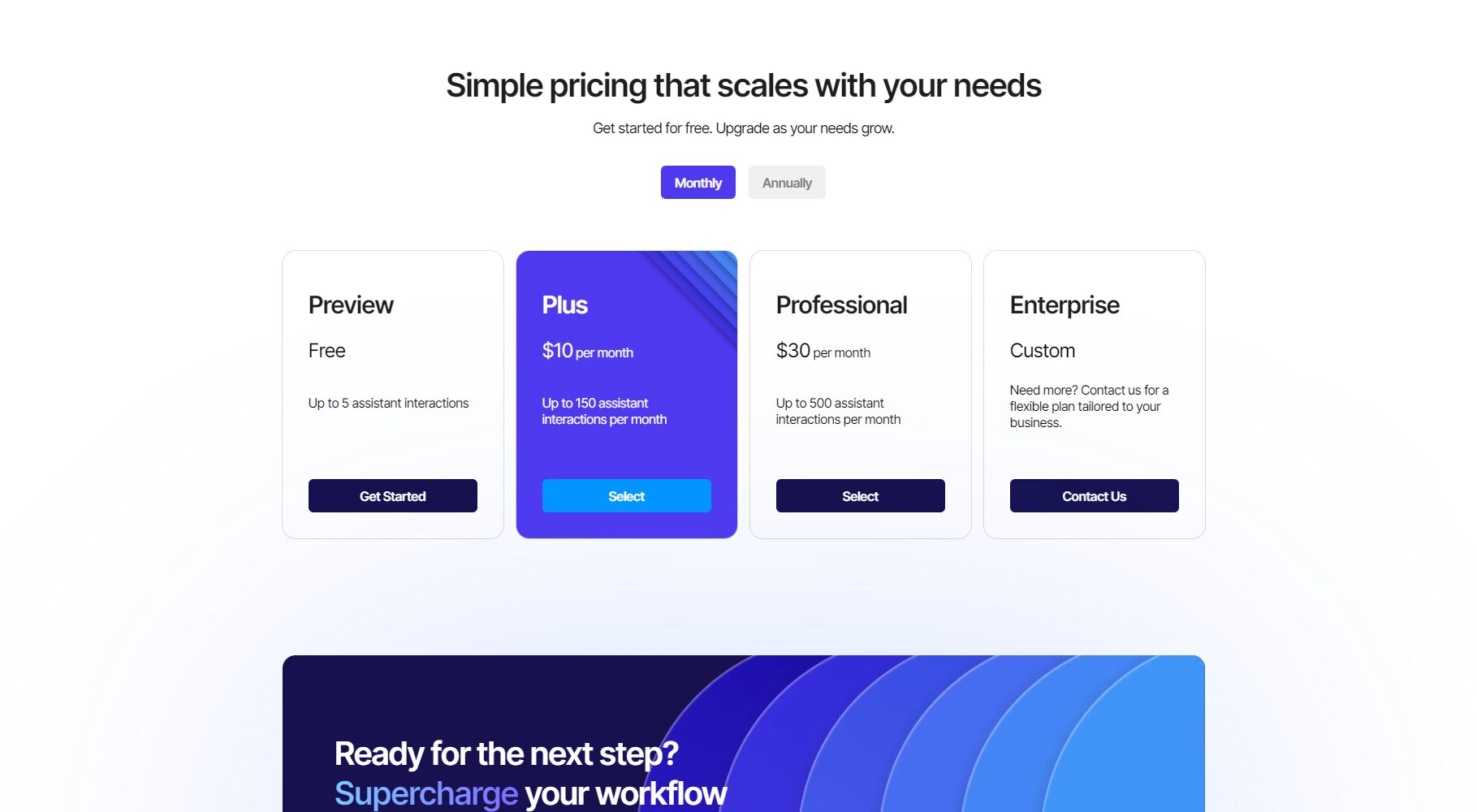

Luminal的價格& 方案

Luminal目前仍在等待名單(Waitlist)模式,主要計費分為按量計費與企業客製兩類,採用Serverless Inference的AI效率提升付費模式,僅對實際推理API呼叫計費,無GPU閒置費用,大幅降低企業支出。

| 方案類型 | 適用對象 | 計費方式 | 核心特性 | 獲取方式 |

|---|---|---|---|---|

| 個人/開發者 | 學術/個人研發 | 按呼叫計費 | 免費額度+超出計費,快速部署 | 加入Waitlist |

| 企業/研究團隊 | 企業/機構 | 階梯用量+套餐 | 客製化服務,私有雲支援 | 聯繫團隊 |

| 開源本地體驗 | 開發者/學術 | 免費/開源 | 自行建置試用,社群支持 | GitHub |

如何使用Luminal

Luminal設計極簡,將AI模型加速與自動部署流程集合於一體。

- 上傳模型——支援上傳Huggingface、PyTorch等主流格式模型和權重。

- 一鍵編譯與最佳化——平台自動分析神經網路並產生GPU程式碼。

- 取得API端點——立即獲得API呼叫RESTful等主流協定介面。

- 調用/集成——面向科研、產品或內網系統,實現推理批量調用和彈性擴展。

- 監控與統計——即時查看推理速度、調用量、冷啟動延遲等關鍵指標。

# 偽代碼示範import luminal model = luminal.load('your_model.pt') endpoint = luminal.deploy(model) result = endpoint.predict(input_data)

大大降低了工程部署與維護門檻! 更多開發文件見 Luminal GitHub專案。

Luminal的適用人群

- AI研究人員/ 實驗室團隊:從模型原型到生產部署無縫銜接

- AI開發工程師/ 資料科學家:節省GPU調優與程式碼工程時間

- 企業級AI主管/ CTO:加速上線與降低雲端資源費用

- 新創及中小型公司:低成本享用頂級推理性能

- 數據分析與創新業務團隊:大數據AI驅動清洗與處理輕鬆實現

| 產業場景 | 應用描述 |

|---|---|

| 金融風控 | 自動化風控模型動態部署、高同時推理支持 |

| 生物醫療 | 醫療診斷即時處理與大數據分析 |

| 智慧客服 | 大型客服中心NLU模型快速升級 |

| 電子商務 | 商品檢索/個人化推薦模式彈性擴容 |

| 科學研究機構 | 實驗模型發布與復現實驗推動產業轉化 |

Luminal的資料處理能力簡介

除了AI模型推理,Luminal也專注於資料處理。例如,針對結構化資料和大型電子表格,平台擁有AI自動清洗、轉換與分析能力:

- 支援自然語言資料查詢與操作,Prompt自動產生Python腳本

- 可應對TB級大數據清洗分析

Luminal平台的技術團隊及發展願景

Luminal創始成員曾在Intel、Amazon、Apple等公司帶隊研發AI算子優化與編譯器,獲頂級孵化器Y Combinator支援。平台願景是讓每個AI團隊不用操心硬體調優,把更多精力用於演算法創新與業務落地,加速AI普及與產業化。

常見問題(FAQ)

Luminal如何保證模型加速的相容性?

本平台採用自動算子分析及高階硬體抽象,相容主流PyTorch、Huggingface框架,CUDA程式碼適配各主流GPU/雲端服務,適應未來算力升級。

Serverless部署如何免除冷啟動和閒置費用?

Luminal利用智慧快取和串流權重加載,將冷啟動延遲降至極低,無須為GPU空閒付費,資源彈性擴充。

如何申請試用或取得企業方案支援?

開發者可透過官網waitlist申請試用,企業可直接電子郵件聯絡Luminal團隊客製化服務。

Luminal作為當下AI推理和高效資料處理領域的領導者,正驅動AI模型「上雲即用」、極簡高效新範式。如果你是AI創新者、企業資料主管,抑或希望為開發團隊降本增效,Luminal無疑值得持續關注與嘗試。未來,隨著模式複雜度升級及算力普惠,Luminal將更大程度釋放AI生產力,為產業帶來更多可能。點擊了解更多Luminal資訊

數據統計

數據評估

本站AI 喵導航提供的Luminal都來自網絡,不保證外部鏈接的準確性和完整性,同時,對於該外部鏈接的指向,不由AI 喵導航實際控制,在2025年11月15日下午10:14收錄時,該網頁上的內容,都屬於合規合法,後期網頁的內容如出現違規,可以直接聯繫網站管理員進行刪除,AI 喵喵不承擔任何責任。

相關導航

象寄翻譯

超級履歷WonderCV

SkimIt.ai

法行寶

Brancher.ai

通義萬相

Writers brew AI