2024年6月,人工智慧大語言模型步入規模化時代。 DeepSpeed,由微軟研發並開源,以其卓越的優化技術成為全球AI開發者的重要工具。DeepSpeed具備高效率的多GPU、多機分散式訓練能力,使得大規模AI模型訓練更為高效、成本更低。其核心技術包括DeepSpeed-Training、DeepSpeed-Inference、DeepSpeed-Compression以及DeepSpeed4Science四大支柱。使用者可以在本地或Azure雲端部署,體驗免費且高效能的AI模型訓練。

2024年6月,人工智慧大語言模型狂飆突進,從GPT-4、BLOOM到最新的企業級應用,大規模AI訓練模型已成為業界力爭高地。隨著模型參數量步入數十億,甚至數千億級,訓練和推理的成本與難度也呈指數級增長。由微軟研發並開源的DeepSpeed,正以其極致的優化技術,徹底改變這一局面,成為全球AI開發者不可或缺的「基礎設施」。

造訪DeepSpeed官方網站:https://www.deepspeed.ai/

什麼是DeepSpeed?

DeepSpeed 是一款深度學習優化軟體套件(Deep Learning Optimization Software Suite),專為訓練和推理超大規模模型打造,普遍應用於如MT-NLG、BLOOM、Jurassic-1等頂級大型模型的訓練場景。 DeepSpeed追求極致高效,主打在多GPU、多機分散式環境中,將訓練速度最大化、資源利用最優、成本大幅降低。

它不僅適用於大模型,也能讓中小型團隊在更平價硬體上完成以往需「巨無霸」伺服器叢集的任務。

DeepSpeed的主要功能

技術創新四大支柱

DeepSpeed的核心創新分為四大支柱,每一項都針對AI訓練與推理中的痛點:

| 支柱 | 主要功能 |

|---|---|

| DeepSpeed-Training | 設計用於突破性的大規模平行訓練(如ZeRO、3D-Parallelism、Mixture-of-Experts、ZeRO-Infinity等),大幅提升訓練效率與規模。 |

| DeepSpeed-Inference | 透過張量、管線、專家模型、ZeRO等多種平行技術和核心優化,實現超大模型的高效低延遲推理。 |

| DeepSpeed-Compression | 提供易用、高靈活度的模型壓縮方案(如ZeroQuant、XTC等),在不影響表現下大幅減少模型體積、加速推理速度、節省成本。 |

| DeepSpeed4Science | 結合系統優化與科學算力,協助生命科學、物理等前沿領域,大幅提昇科研AI模型的訓練效率。 |

詳細技術介紹可查閱 DeepSpeed技術支柱頁面。

DeepSpeed-Training

- 突破性分散式訓練優化,如ZeRO系列優化器,使多節點數千GPU上線性擴展,輕鬆支撐千億參數模型訓練。

- 3D-Parallelism,實現張量、管線、資料三維並行,極致挖掘計算與記憶體頻寬。

- MoE(專家模型)訓練優化,自動管理稀疏啟動大模型,訓練稀疏參數更有效率。

DeepSpeed-Inference

- 超大模型低延遲推理,結合自研高性能推理內核和通訊優化,千億級模型也能快速、多並發服務上線。

- 異質記憶體調度,支援CPU+GPU/NVMe混合存儲,大幅降低顯存需求。

DeepSpeed-Compression

- 壓縮與量化一體化,內建ZeroQuant、XTC等尖端技術,支援全自動壓縮,方便預測部署。

- 靈活並可組合的壓縮API,兼容科研與工業需求。

更多詳見 DeepSpeed功能列表。

DeepSpeed的價格& 方案

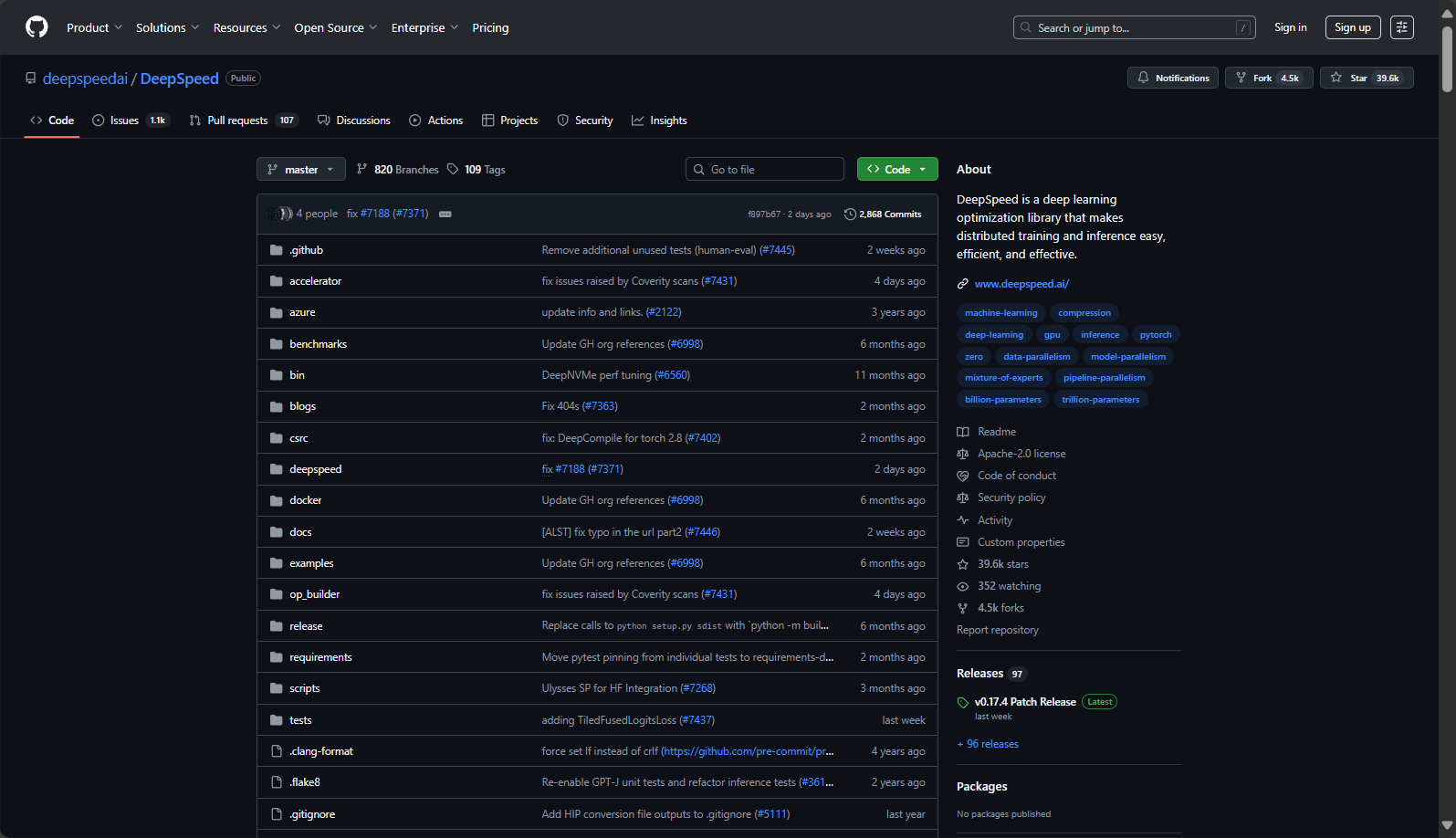

DeepSpeed完全開源免費,用戶可以在GitHub快速取得原始碼,企業商用、科研均可無門檻使用。官方還提供:

- 深度Hugging Face Transformers、PyTorch、PyTorch Lightning集成,降低模型遷移與二次開發門檻。

- 微軟Azure 上完整支持,可直接透過AzureML一鍵開啟分散式訓練。詳見 AzureML官方指引。

| 方案 | 價格 | 適用場景 |

|---|---|---|

| 開源本地部署 | 免費 | 內部或研究資料、可自訂環境 |

| Azure雲端AI訓練 | 按雲端資源計費 | 彈性擴展、高效能叢集、大規模生產環境 |

| 社區支持與企業合作 | 部分商業服務費 | 客製化技術支援、行業級持續集成 |

DeepSpeed不收取獨立授權或使用費,社區與企業服務請參見DeepSpeed社區。

如何使用DeepSpeed

安裝

DeepSpeed支援Linux、Windows、主流GPU架構(包含NVIDIA、AMD、Intel支援),簡單pip一行即可:

pip install deepspeed詳細環境&加速器支援見 設備相容性列表。

快速整合訓練/推理程式碼

以PyTorch為例,只需三個步驟:

1. 配置DeepSpeed參數(ds_config.json)

{ "train_batch_size": 8, "gradient_accumulation_steps": 1, "optimizer": {"type": "Adam", "params": {"lr": 0.00015}}, "fp16": {"enabled": trueopt =

2. 初始化DeepSpeed引擎(訓練範例)

import deepspeed model, optimizer, _, _ = deepspeed.initialize(args=cmd_args, model=model, model_parameters=params)3. 啟動分散式訓練指令

deepspeed --num_gpus=4 --deepspeed --deepspeed_config ds_config.json詳細用法可見官方入門教學。

雲端一鍵試用

微軟Azure透過AzureML提供DeepSpeed模板,適合雲端運算彈性資源的大規模AI訓練場景。

Hugging Face、Lightning原生集成

一句指令+config即可讓Transformers、PyTorch Lightning任務接入DeepSpeed加速,見 HF整合教程。

DeepSpeed的適用人群

| 角色 | 使用價值 |

|---|---|

| AI研發團隊 | 訓練千億參數大模型,大幅降低成本與開發難度 |

| AI新創公司 | 利用開源集群,低門檻實現業界領先的模型訓練 |

| 學術科學研究團隊 | 擴展論文級實驗規模,推動大模型理論與新演算法突破 |

| 雲端服務&大廠 | 面向SaaS/PaaS AI服務,支撐超高並發與大模型推理低延遲部署 |

| DL框架開發者 | 深度整合分散式最佳化與模型壓縮技術,開放自訂最佳化與插件框架 |

適合一切對AI訓練模型有高性能、低成本、易擴展需求的企業與個人。

DeepSpeed整合與生態

DeepSpeed擁有高度開放與豐富的生態:

- 與主流DL框架無縫集成:如Hugging Face Transformers、Accelerate、PyTorch Lightning、MosaicML等一鍵對接,

- 案例見整合文檔。

- 支援雲端原生與本地部署:Azure、Kubernetes等平台均有官方部署範例。

- 主流AI大模型標配:MT-530B、BLOOM、Jurassic-1、GLM、GPT-NeoX等皆使用DeepSpeed完成訓練/推理。

常見問題

DeepSpeed支援的分散式AI訓練有哪些類型?

DeepSpeed支援資料並行(Data Parallel)、模型並行(Model Parallel)、流水線並行(Pipeline Parallel)、張量並行(Tensor Parallel)、專家模型並行(Expert Parallel)等主流訓練範式,協同ZeRO等創新演算法,適用於從單機多瓶到千卡機組,極大地減少各種場景。

- 更多ZeRO分散式說明見 官方培訓技術頁面。

如果預算有限,DeepSpeed是否也適合中小型團隊?

是的。 DeepSpeed創新的記憶體管理和分散式策略能讓中小型團隊利用市售單機伺服器、雲端中低配GPU實現以往只有「AI巨頭」能完成的超大模型訓練。並且其對CPU、NVMe等儲存的異質優化,降低高配硬體投入門檻。部署參考 資源配置文檔。

DeepSpeed對推理部署和模型壓縮有什麼幫助?

DeepSpeed-Inference和DeepSpeed-Compression可將百億參數模型輕鬆「裝下」8G及以上顯存卡,並顯著提升推理並發能力和速度。 ZeroQuant等技術還能實現極低成本的W4A8等量化模型,方便邊緣/低頻寬場景部署。查看 推理技術頁面 和 壓縮功能 取得詳細資料和開源工具。

隨著大模型時代全面到來,DeepSpeed已成為AI訓練模式的核心引擎。它的開源開放與極致效能,讓從初學者到AI巨擘都能按需建立屬於自己的智慧模型。無論你身處AI科研、工業落地或雲端原生服務,DeepSpeed都是你探索AI邊界、提升效率與控製成本的強力臂膀。立即前往DeepSpeed官網,開啟AI訓練的無限可能。

數據統計

數據評估

本站AI 喵導航提供的DeepSpeed都來自網絡,不保證外部鏈接的準確性和完整性,同時,對於該外部鏈接的指向,不由AI 喵導航實際控制,在2025年8月7日上午11:53收錄時,該網頁上的內容,都屬於合規合法,後期網頁的內容如出現,可以直接聯繫網站管理員進行刪除,AI 導航喵不承擔任何責任。

相關導航

法行寶

繪蛙AI高清

Hitems

Pixelcut.ai

Whisper Memos

Hama

UpSlide