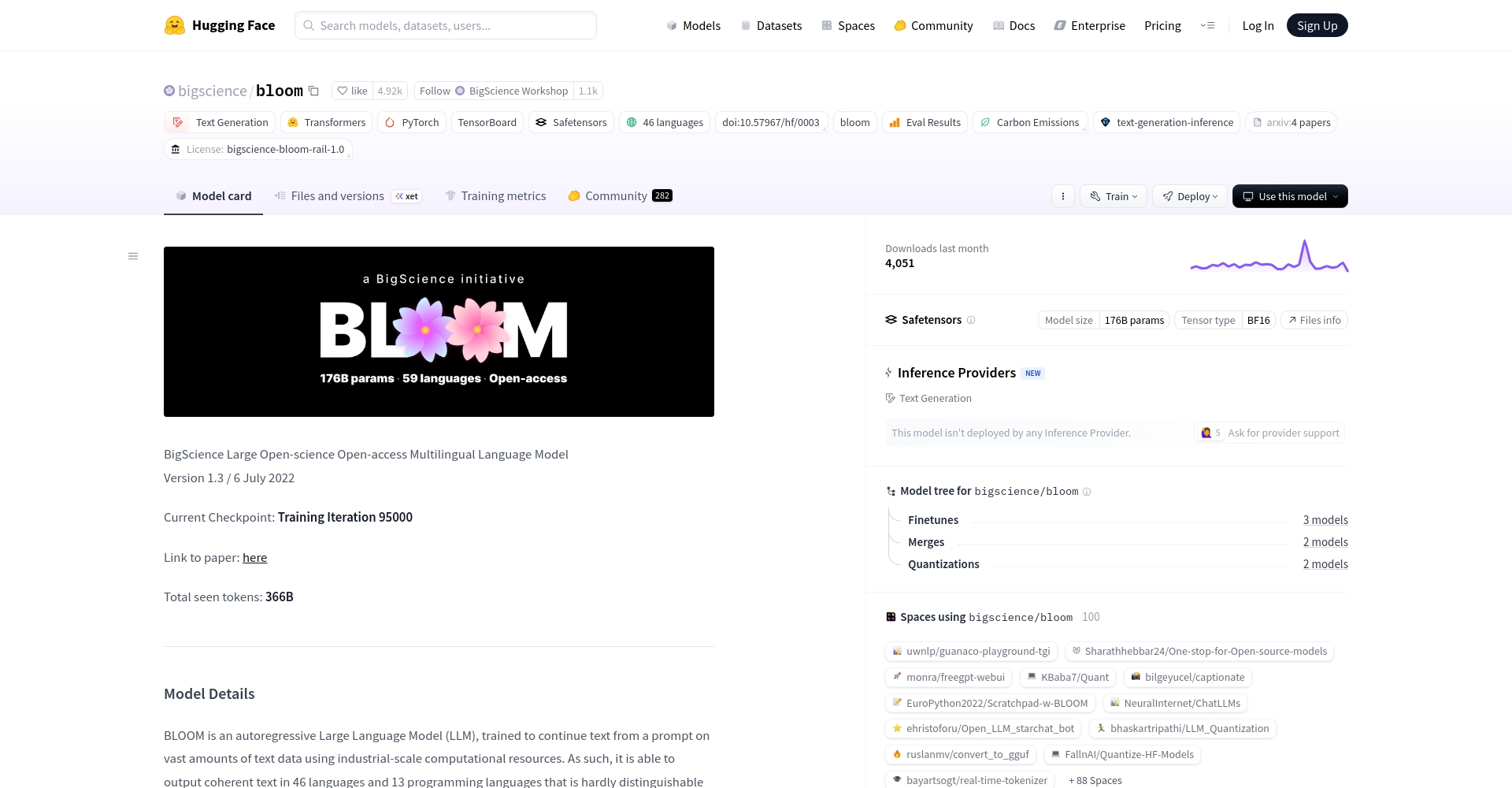

BLOOM:開啟大規模多語種開源AI 訓練模型的新時代。 BLOOM是由全球數百名AI研究者共同推出的生成式大型語言模型,具有超大規模參數、多語言覆蓋和開放的特性,支援46種自然語言和13種程式語言。 BLOOM的發布象徵AI研究的自由與開放,以其強大的生成能力與適用性為業界注目。

BLOOM的主要功能

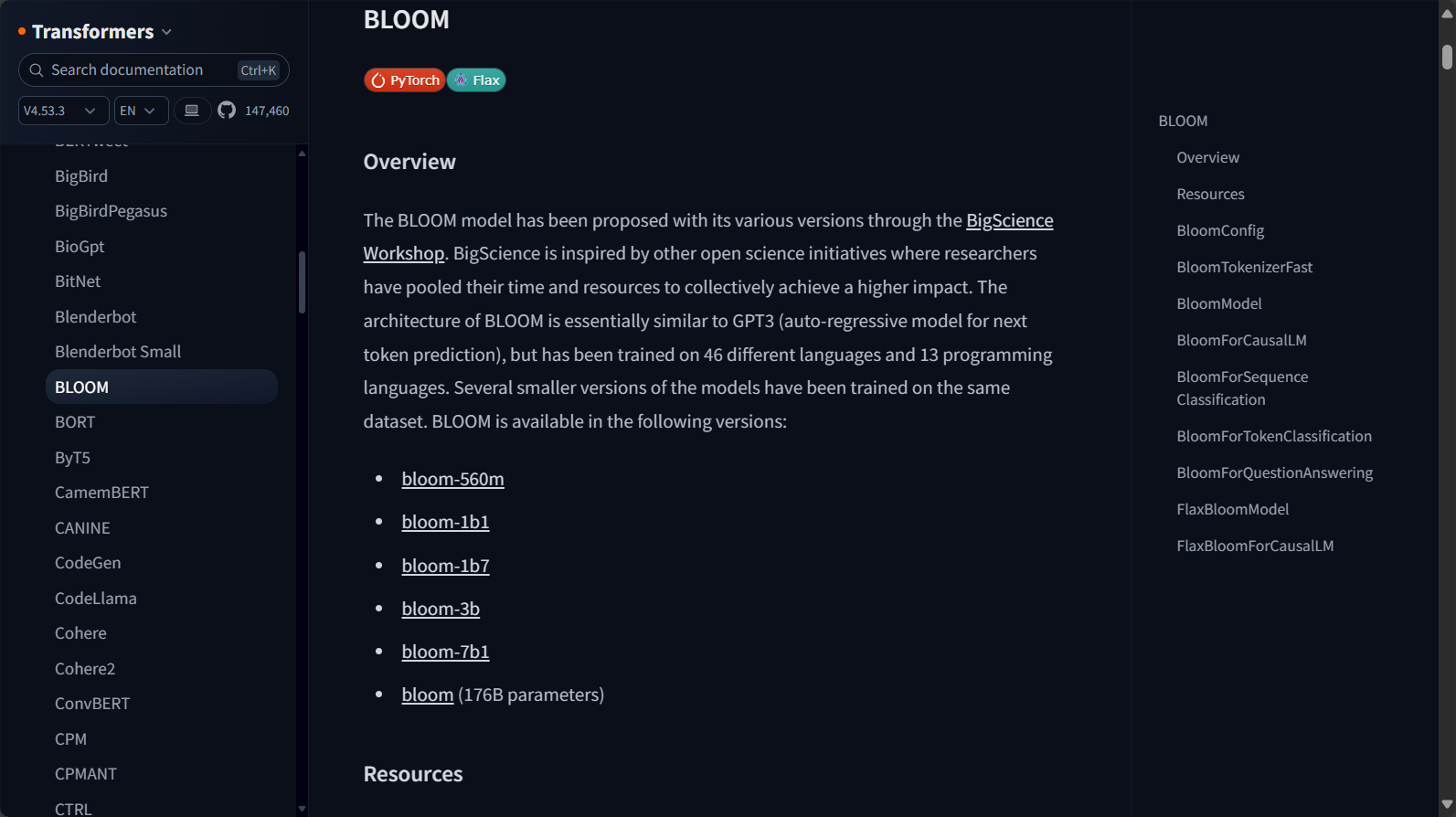

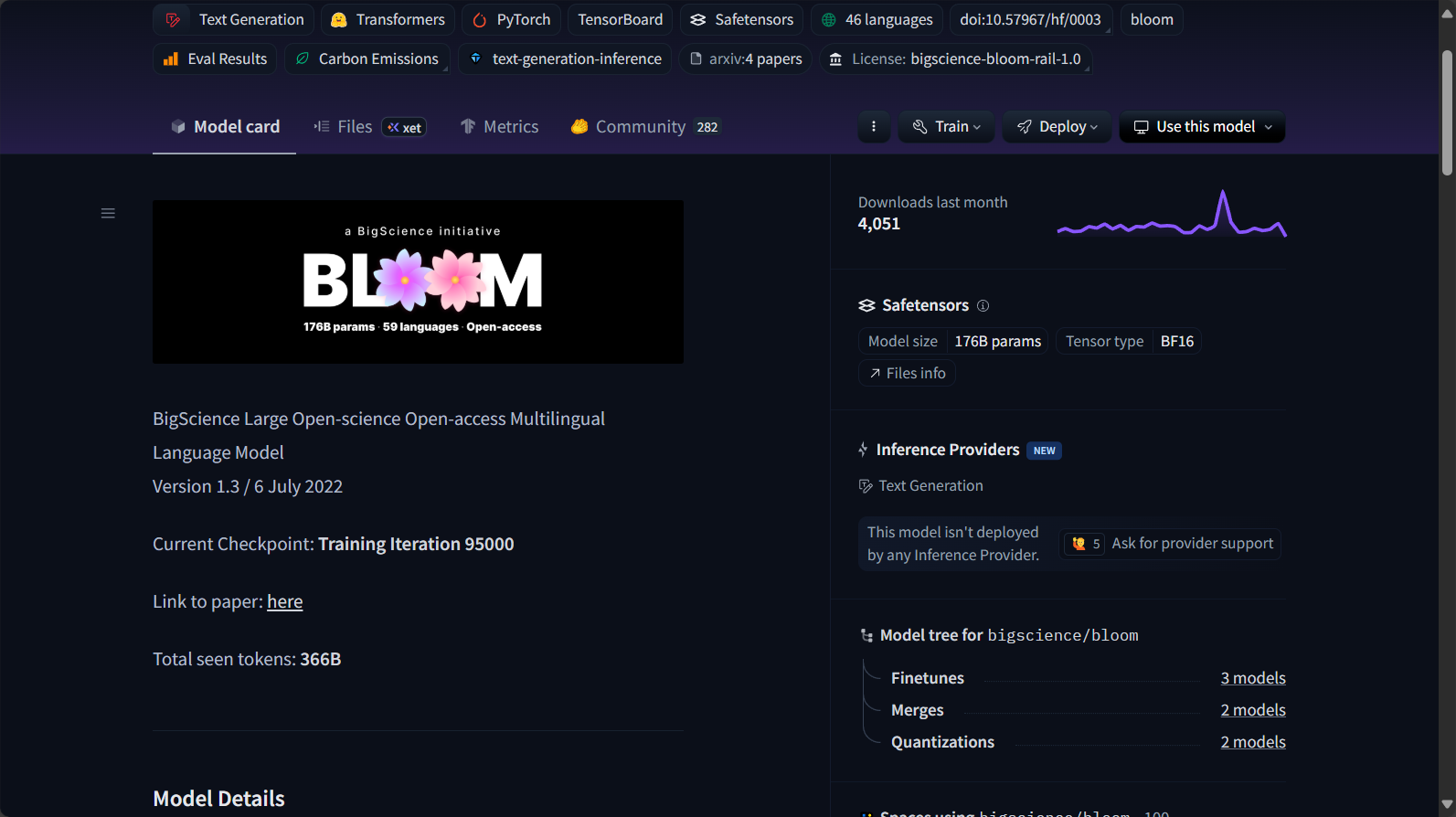

BLOOM是一個自回歸生成式大型語言模型,採用transformer架構,擁有高達1760億參數,支援46種自然語言和13種程式語言。此AI訓練模型是由BigScience Workshop在法國Jean Zay超級電腦上開發訓練,旨在推動透明、可重複使用、開放的AI研究生態。其優勢體現在:

- 多語言支援:涵蓋英語、法語、中文、印地語、阿拉伯語等。

- 強大生成能力:可根據使用者提示產生連貫、類人的文字。

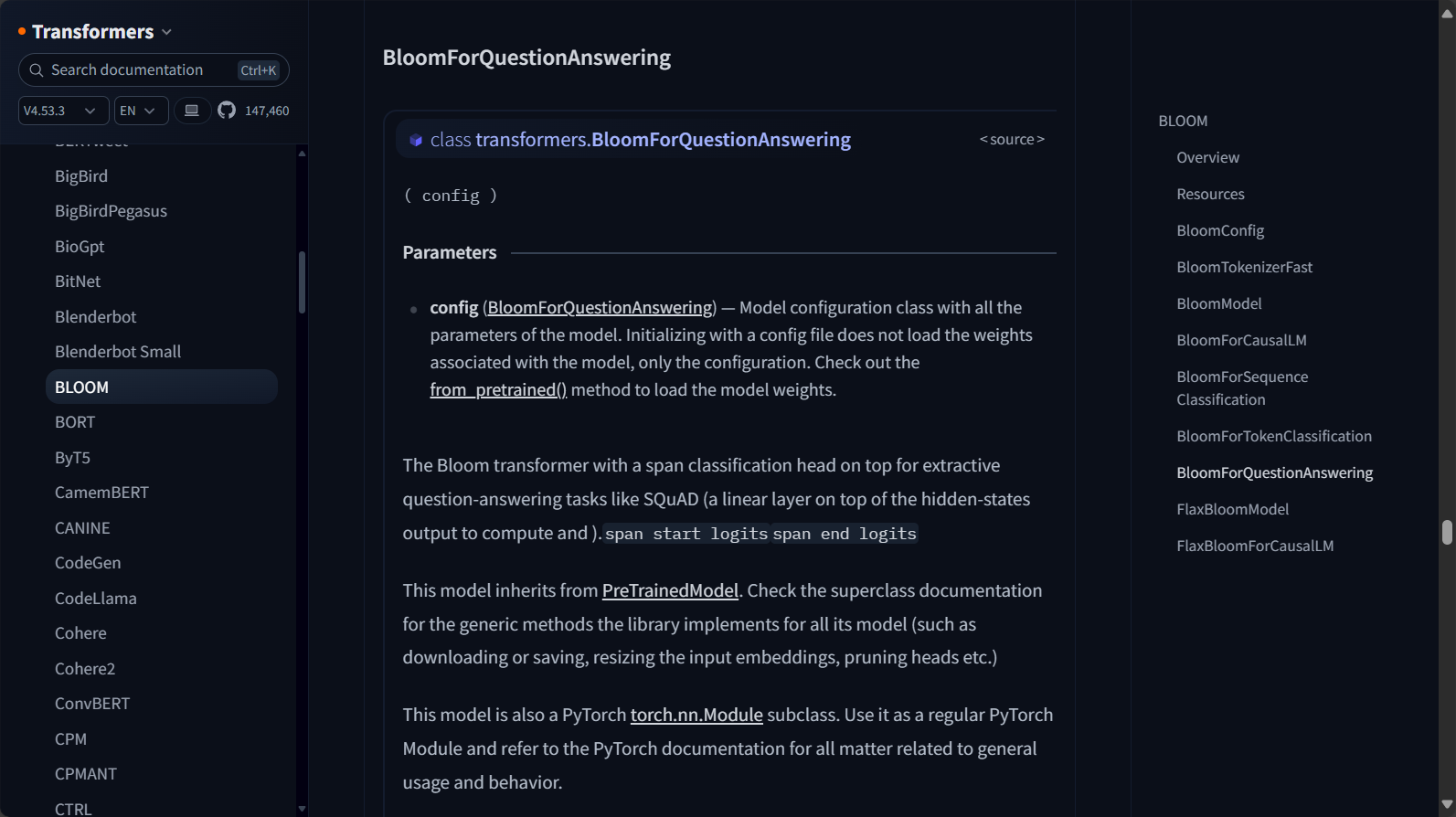

- 下游任務遷移:易於微調於摘要、問答、翻譯、資訊抽取等NLP任務。

- 程式語言相容:對Python、Java、C++等主流程式語言有良好表現。

- 完全開源/可下載:任何人均可通過Hugging Face免費取得與部署。

例如,BLOOM能輕鬆實現以下功能(來源:功能頁面鏈接):

| 功能類型 | 說明 |

|---|---|

| 文字生成 | 續寫、對話、短文創作 |

| 摘要/資訊抽取 | 自動產生文字摘要、提取關鍵訊息 |

| 程式碼補全 | 多種程式語言的程式碼補全與生成 |

| 語義理解 | 某些形式下可處理閱讀理解、問題回答 |

| 多語言翻譯 | 支援多語言互譯(非專業MT,但可做demo、實驗) |

BLOOM的資料多樣性統計

BLOOM在AI訓練過程中採用了極為多元化的語料庫,具體包括以下表格:

| 語言或類型 | 數量/比例 |

|---|---|

| 自然語言 | 46 |

| 程式設計語言 | 13 |

| 預處理文字規模 | 1.6 TB |

| 訓練Token數 | 3500億(350B) |

| 支援最大文字長度 | 2048 Token |

更多模型細節參見官方Hugging Face文檔。

BLOOM的價格& 方案

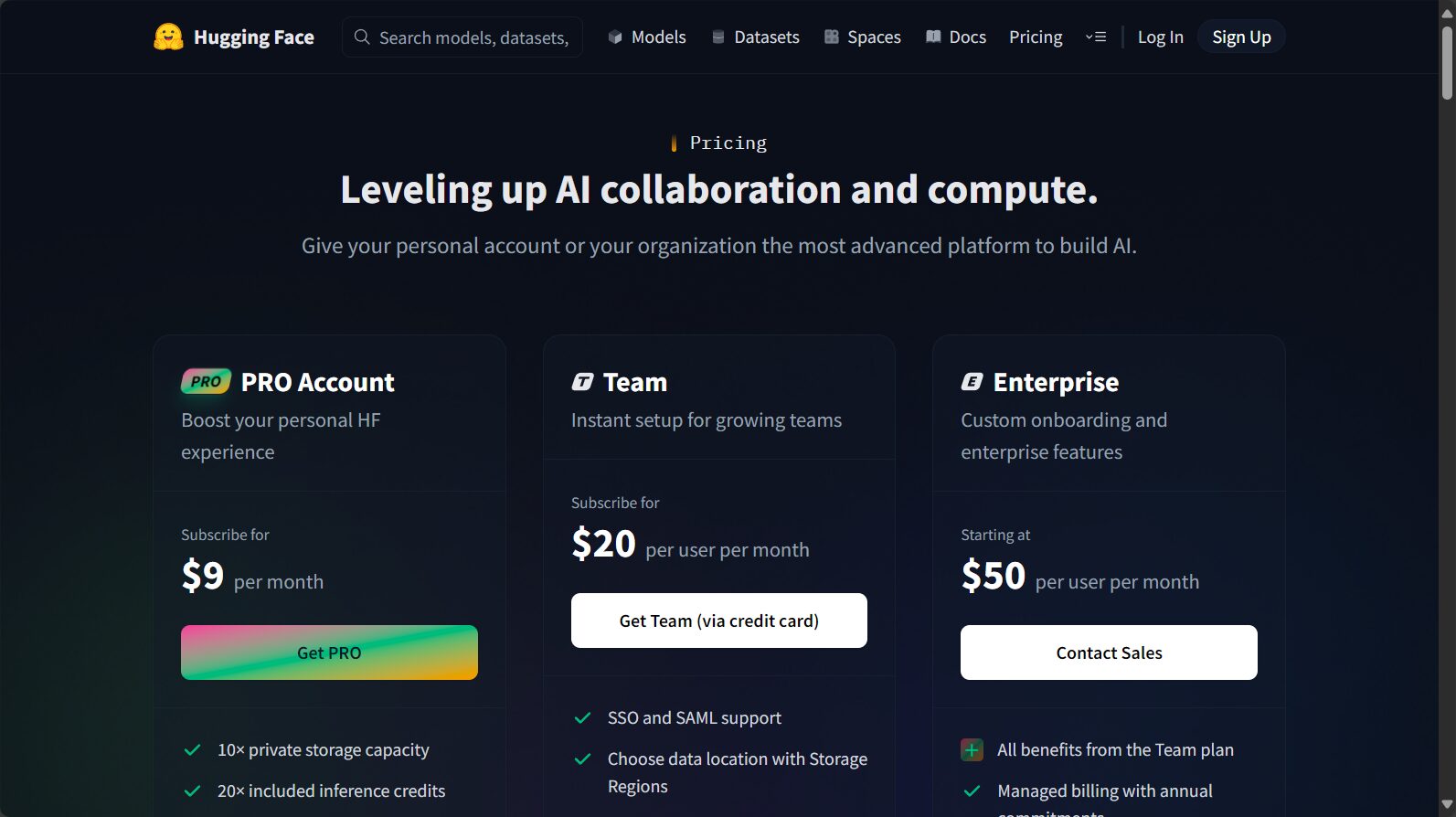

BLOOM作為開源模型,其基礎模型完全免費,所有人都可透過Hugging Face下載和本地部署,無需支付任何授權費用。

BLOOM的發布遵循BigScience RAIL許可協議,允許個人、研究機構、社會團體免費使用和修改,但需明確不可用於違反倫理與法律的場景。如果使用雲端推理服務、客製化API或企業級部署,Hugging Face可能另有付費方案,但這屬於雲端廠商、平台方的加值服務,與BLOOM模型本身開源屬性無衝突。

查閱更多價格和部署細節,可訪問Hugging Face定價頁。

如何使用BLOOM

BLOOM的設計強調“開箱即用”,支援多平台多框架呼叫。開發者可透過以下幾種方式:

- 直接下載權重與tokenizer,在本地用PyTorch/Transformers載入使用。

- 透過Hugging Face介面直接雲端推理(需註冊和API金鑰)。

- 支援微調(Fine-tune)/遷移學習,滿足特定業務需求。

快速使用範例(參見官方快速上手文檔):

from transformers import AutoModelForCausalLM, AutoTokenizer

tokenizer = AutoTokenizer.from_pretrained("bigscience/bloom")

model = AutoModelForCausalLM.from_pretrained("bigscience/bloom")

prompt = "请简要介绍BLOOM模型的主要功能。"

inputs = tokenizer(prompt, return_tensors="pt")

outputs = model.generate(**inputs, max_new_tokens=100)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))如果只需小規模嘗試,Hugging Face Spaces中也有可互動的Web Demo。

硬體需求說明表:

| BLOOM參數規模 | 最佳硬體建議 |

|---|---|

| 176B參數全量版 | 多張A100 GPU/企業級伺服器 |

| 7B/3B/1B版本等輕版 | 單張高階GPU即可 |

BLOOM的適用人群

BLOOM定位“開源開放、技術前沿”,因而適合以下群體:

- 學術研究者及大學師生:可做NLP課題研究、成果重現、模型微調等。

- AI開發者與工程師:整合至產品原型、進行AI能力驗證。

- 多語言應用程式開發商:服務跨國企業或語言多元用戶群。

- 數據科學家:用於特定語域、領域知識擷取、自訂任務。

- 開源社群貢獻者:進行模式優化、評測、配套工具開發等。

- 程式設計教育與自動化工具開發者:實驗AI程式碼產生/補完功能。

應用實例範圍對照表:

| 應用程式類型 | 示範價值 |

|---|---|

| 多語言文件產生/摘要 | 自動合成多語言訊息 |

| 問答、對話機器人 | 建構支援多種語言的助手 |

| 程式碼理解與補全 | 支援學科程式輔助 |

| 跨語種內容創作 | 全球使用者內容自動化 |

| 低資源語言研究 | 推廣語言多樣性保護 |

詳細適用人群及操作建議,也可查閱官方說明文檔。

BLOOM技術架構與AI訓練模型亮點

模型架構特性

- 採用Decoder-only結構,類似GPT-3,但涵蓋語言較多,具備更優的遷移與泛化能力。

- 參數量高達176B,支援序列長度2048 token,旨在實現更大範圍的語義理解與生成。

| 架構參數匯總 | 配置/說明 |

|---|---|

| 層數 | 70 |

| 注意力頭數 | 112 |

| 隱層維度 | 14336 |

| 詞表大小 | 250,680 |

參考:更多技術詳情

AI訓練模型的多元與公平性

- 數據覆蓋廣泛,包括46種自然語言、13種程式語言,1.6TB高品質文本。

- 強多樣性設計原則,重視低資源語言的Proportional取樣,強調「開源、開放、包容」。

- 模型版本多樣,除176B參數全量版外,還提供7B1、3B等輕量版,方便資源有限用戶使用。

BLOOM的風險、限制與使用建議

限制與風險需正視:

- 非高風險決策工具:模型內容“看似可靠但真實準確性需核查”,不適用於生物醫療、金融、法律等場景直接決策。

- 可能輸出有害內容:如帶偏見、攻擊性、敏感詞彙等。

- 需嚴守倫理與數據合規:遵循RAIL協議,不得違規濫用。

| 主要風險類型 | 具體說明 |

|---|---|

| 觀點偏倚/數據不均衡 | 部分群體資訊出現頻率不同 |

| 個人資訊洩露 | 訓練資料中或有敏感內容 |

| 錯誤訊息產生 | 生成內容非100%事實 |

| 不當領域使用 | 禁止自動評測個體、關鍵判決場景 |

詳見:風險與限制說明文檔。

BLOOM常見問題

BLOOM模型有什麼不同版本,它們如何選擇?

BLOOM提供了從微小型(bloom-560m)到超大規模(bloom-176B)多種參數等級版本。

- 硬體資源有限建議選擇7B、3B等輕量級版。

- 科學研究及高效能需求可選用176B全量版,但需分散式多卡部署。

詳細版本一覽表請見:BLOOM模型列表

BLOOM可以用在商業產品上嗎?

根據開源RAIL協議,BLOOM基本上可用於商業應用(只要不違法、不用於高風險/違規場景),但建議詳細閱讀許可協議,確保不違反附加條款。如涉及雲端API商業調用,還需依照Hugging Face平台額外條款付費。

BLOOM能否自訂微調?對自有數據好用嗎?

BLOOM設計為可遷移/微調的AI訓練模型,開發團隊和社群已給予多種微調實操方案。基於公開Transformers工具包,開發者可在自有資料集上快速適配BLOOM用於分類、標註、產生等下游任務。

微調教學/實戰:可參考官方文檔及社區分享。

結尾

BLOOM已成為推動NLP民主化、AI開放協作的“里程碑”,其多語言能力與開放生態為全球開發者和AI訓練模型愛好者創造了前所未有的創新土壤。無論是科學研究實驗、語言多樣性保護,或是智慧產品原型開發,BLOOM都為你準備了靈活、專業、開放、高效能的AI新典範。如果你有興趣體驗尖端AI的力量,不妨即刻訪問BLOOM官方文檔開啟你的探索之旅,共同推動AI科技的繁榮盛開。

數據統計

數據評估

本站AI 喵導航提供的BLOOM都來自網絡,不保證外部連結的準確性和完整性,同時,對於該外部連結的指向,不由AI 喵導航實際控制,在2025年7月26日下午12:02收錄時,該網頁上的內容,都屬於合規合法,後期網頁的內容如出現違規,可以直接聯繫網站管理員進行刪除,AI 喵導航不承擔任何責任。

相關導航

器友AI反應器

MindsDB

Code Snippets AI

Claude Sonnet 4.5

即構數智人

ImagineMe

輕竹辦公