對於許多初次接觸AI繪畫的朋友來說,”Diffusion”這個詞可能聽起來有些技術化和遙遠。但實際上,它所代表的生成式AI技術,已成為驅動目前絕大多數AI繪畫工具的核心引擎。理解它的基本運作邏輯,是您從單純的「使用者」蛻變為「創作者」的關鍵。

本篇指南將拋棄繁雜的理論,透過五個核心步驟,帶您走過從安裝配置到熟練創作的全過程,讓您清晰地了解每一步「為什麼」以及「怎麼做」。

第一步:搭建你的創作環境-在地部署與雲端平台的抉擇

開啟AI繪畫之旅的第一件事,就是選擇你的「畫室」。目前主流的選擇有兩種:

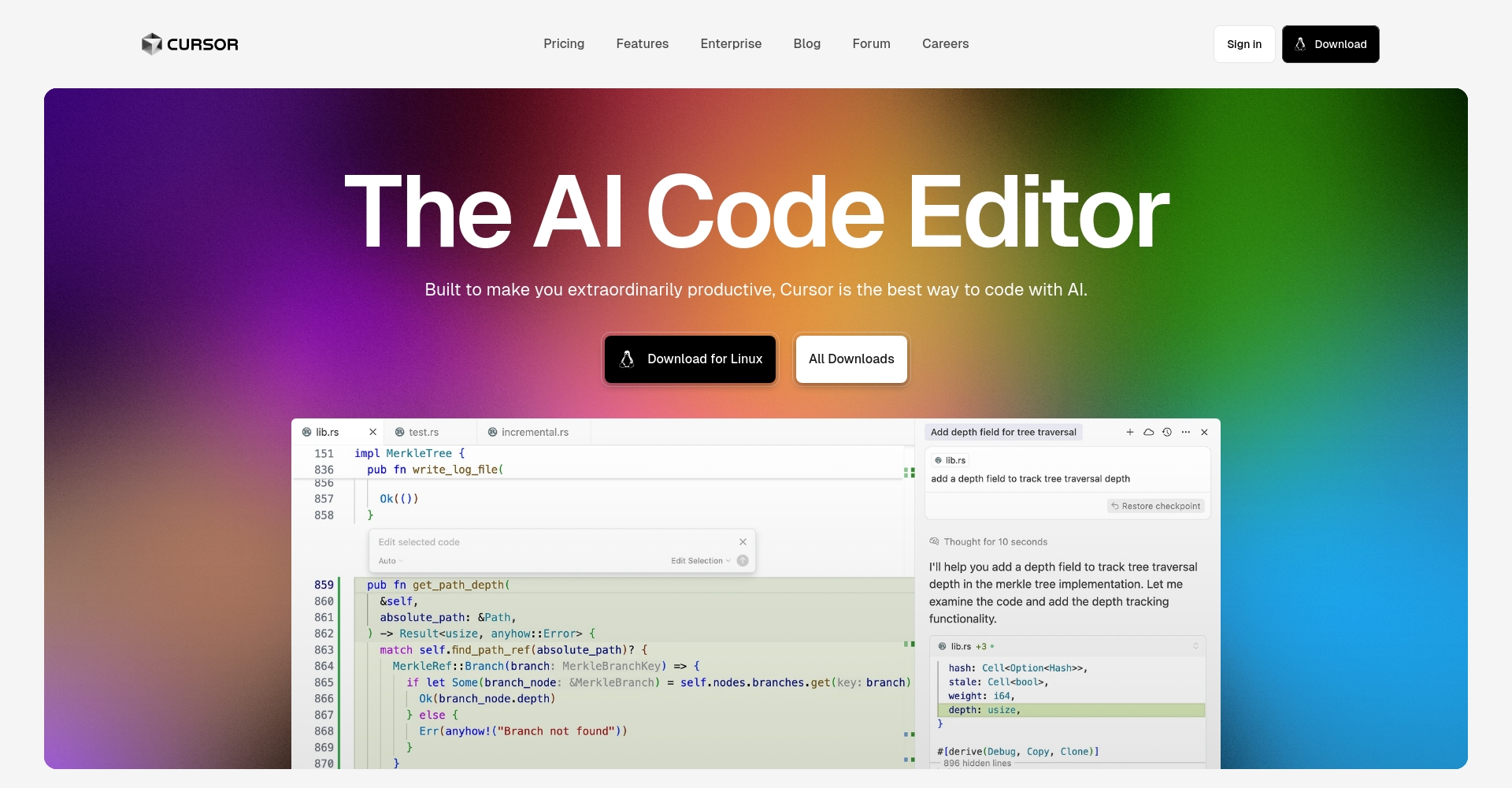

- 本地部署(Local Deployment):這是對創作掌控力最強的方式。你需要在自己的電腦上安裝一套完整的運作環境,其中最受歡迎、社群支持最完善的當屬 Stable Diffusion WebUI (AUTOMATIC1111版)。

- 優點:完全免費(除電費外),無生成數量限制,可自由安裝任何模型和插件,隱私性高,所有創作資料均在本地。

- 缺點:對電腦硬體有要求,通常需要一張擁有至少8GB顯存的NVIDIA顯示卡(A卡透過特定配置也能支持,但N卡生態更成熟)。安裝和設定過程對新手有一定學習曲線。

- 建議:如果你的電腦配置達標,並且希望長期、深入地探索AI繪畫,本地部署是你的不二之G擇。網路上有大量“一鍵安裝包”,可以大大簡化初始設定流程。

- 雲端平台(Cloud Platforms):如果你不想折騰硬體和配置,或只是想快速體驗,雲端平台是絕佳的入口。這些網站已經為你準備好了一切,你只需註冊登錄,即可開始創作。

- 優點:對本地硬體無要求,手機、平板、一般電腦都能流暢使用。介面通常更友好,上手快。

- 缺點:通常有免費額度限制,超出後需付費。在模型和插件的自由度上低於本地部署,部分高級功能可能需要訂閱。

- 推薦平台:

- SeaArt.ai:對新手非常友好,免費額度相對慷慨,社區活躍,有大量現成的模型和LoRA可供直接使用。

- Leonardo.Ai:功能強大,不僅能產生圖片,也提供訓練自己模型的功能,風格偏向歐美遊戲和奇幻藝術。

- Midjourney:雖然它並非嚴格的Diffusion WebUI平台,但作為AI繪畫的標桿,其獨特的藝術風格和高品質的出圖效果值得任何愛好者體驗。它透過Discord社群進行互動。

第二步:選擇你的畫筆靈魂-理解與挑選“模型(Model)”

如果說WebUI或雲端平台是你的畫室,那麼「模型」就是你畫筆的靈魂,它決定了你作品的基礎風格和能力上限。

- 什麼是模型? 簡單來說,模型就是一個經過大量圖片資料訓練的巨大檔案(通常幾GB大小)。它學習了這些數據的風格、構圖、元素關聯性。你輸入的提示詞,其實是在引導這個模型,從它所「學習」到的知識庫中,組合出你想要的畫面。

- 模型的分類與選擇:

- 基座模型(Base Model):如官方發布的

SD 1.5、SDXL 1.0。它們是“通才”,知識面廣,可塑性強,但沒有特別突出的風格。通常作為訓練其他模型的基礎。 - 微調模型(Fine-tuned Model):這是社區創作的主力。創作者使用特定風格的資料(如二次元、寫實攝影、水墨畫等)在基座模型上進行“二次訓練”,使其成為擅長特定領域的“專才”。

- 寫實類推薦:

ChilloutMix,Realistic Vision - 二次元類推薦:

Anything系列,Counterfeit

- 寫實類推薦:

- 哪裡找模型? Civitai(俗稱C站)是目前全球最大、最活躍的AI繪畫模型和資源分享社群。你可以在這裡找到並下載幾乎所有類型的模型、LoRA以及優秀的範例作品與提示詞。國內也有如 哩布哩布(LiblibAI) 等優秀的平台可供選擇。

- 基座模型(Base Model):如官方發布的

第三部:學習溝通的藝術-精通提示詞(Prompt)的語法

提示詞是人與AI溝通的橋樑。其品質直接決定了出圖效果的下限。一個好的提示詞結構通常是:

正向提示詞(Positive Prompt):告訴AI你「想要什麼」。

- 結構化書寫:建議遵循

畫質詞+ 主體描述+ 環境與背景+ 風格與藝術家+ 構圖與光照的順序。- 範例:

(masterpiece, best quality), 1girl with long silver hair, standing in a magical forest at night, fireflies glowing around, by Makoto Shinkai, cinematic lighting, dynamic angle.

- 範例:

- 質量詞綴:

masterpiece, best quality, ultra-detailed等詞彙能有效提升畫面整體品質。 - 權重語法:使用

(word:1.2)增加該詞彙的權重,或[word]降低權重,可以更精細地控制畫面元素。

反向提示詞(Negative Prompt):告訴AI你「不要什麼」。

- 作用:過濾掉模型在訓練中可能學到的“壞習慣”,如崩壞的手、多餘的肢體、低品質的畫面等。

- 通用模板:一套好的反向提示詞可以大幅改善出圖品質。例如:

(worst quality, low quality:1.4), bad hands, extra fingers, mutated hands, disfigured, text, watermark, blurry.你可以在C站等社區找到許多優秀的、可以直接複製使用的反向提示詞模板。

第四步:駕馭創作的控制台-核心參數解讀

如果提示詞是劇本,那麼參數就是導演手中的控制面板,它們決定了劇本如何被演繹。

- 採樣方法(Sampler):AI生成圖片的過程,是從一張純噪音圖逐步「去噪」變清晰的過程。採樣方法就是「去噪」所遵循的演算法。不同的演算法會帶來細微的風格和速度差異。

- 新手推薦:

Euler a(速度快,富有創意,適合初期探索)、DPM++ 2M Karras(出圖穩定,細節好,適合最終出圖)。

- 新手推薦:

- 採樣步數(Steps):即「去雜訊」的步數。步數太少,畫面可能模糊不清;步數太多,效果提升有限且耗時。通常

20-30步是兼顧速度與品質的甜點區。 - CFG Scale (提示詞相關性):控制AI對你提示詞的「遵從度」。數值越低(如4-6),AI越自由發揮,畫面可能更有藝術感但偏離你的描述;數值越高(如8-12),AI越嚴格遵循你的描述,畫面更精準但可能略顯死板。

7是一個非常通用的起始值。 - 種子(Seed):每一張AI圖片的生成,都始於一個隨機的「種子」值。如果種子設為-1,每次都會產生一張全新的圖片。如果你得到一張很滿意的圖,可以複製它的種子值並固定下來。這樣,你就可以在此基礎上微調提示詞,而畫面的主體構圖和人物將保持不變,這對於角色一致性和風格探索至關重要。

第五步:邁向自由創作-了解LoRA與ControlNet

當你熟練以上步驟後,可能會遇到新的瓶頸:如何讓AI畫出特定的人物角色?如何精準控制人物的姿勢?這時,你需要了解兩個進階工具:

- LoRA (Low-Rank Adaptation):可以將其理解為一個外掛的“風格/角色補丁”。它是一個小檔案(通常幾十到幾百MB),載入後能讓你的主模型學會畫某個特定的角色、服裝或畫風。這是實現角色一致性最主流的方法。

- ControlNet:這是一個強大的插件,允許你用一張圖片(如火柴人姿勢圖、建築線稿、景深圖)來精確控制生成圖像的構圖、姿勢、輪廓。它將創作的主導權從AI手中進一步交還給你,實現了從「語意引導」到「幾何控制」的飛躍。

結語

AI繪畫的學習之路,更像是一場充滿探索樂趣的實驗。不必畏懼繁多的參數和概念,從選擇一個你喜歡的雲端平台或搭建好本地環境開始,挑選一個心儀的模型,然後大膽地去嘗試、去修改、去組合你的提示詞。每一次點擊“生成”,都是新的發現。當你能穩定地創作出心中所想的畫面時,你已經是一位合格的AI創作者了。

© 版權聲明

文章版權歸作者所有,未經允許請勿轉載。

相關文章

暫無評論...