Luminal A new generationAI模型推理加速与数据处理平台,支持主流AI框架模型在各类硬件上的极速部署与高效运行。它通过自动化编译和无服务器部署,大幅降低开发者、企业的运维负担,是AI效率提升领域的创新工具。平台还集成大规模结构化数据与表格的AI清洗处理能力,非常适合科研、商业场景使用。

在当今AI技术百花齐放的时代,Luminal 以其精妙的AI模型加速和大型数据处理能力,成为众多开发者与企业关注的焦点。从帮助研究团队高效部署模型,到企业级海量数据清洗和分析,Luminal 正以创新思维重塑AI开发部署流程。本文将以新闻报道形式,深入解析Luminal平台的核心功能、适用场景、用户操作体验与价格布局,并结合官方与市场公开信息为广大AI从业者、开发者、数据工程师呈现立体视角。

Official website:https://getluminal.com

Luminal的主要功能

一站式AI模型优化与零运维部署

Luminal 的核心使命是“让AI模型在任何硬件上都能极速运行”。它通过自主研发的ML编译器和CUDA内核自动生成技术,将PyTorch等主流框架下的AI模型转换为针对GPU高度优化的代码,实现10倍以上推理速度提升,极大地降低了硬件与云端计算成本。

| Functional categories | Detailed description |

|---|---|

| 模型优化 | 自动分析模型算子结构,生成最优GPU内核代码,不依赖人工手写优化 |

| 极致加速 | 堪比手写Flash Attention等高阶内核,实现业内顶级推理速度 |

| Automated deployment | 无服务器(Serverless)推理,只需上传权重,即可获得API端点 |

| 智能冷启动 | 编译缓存与参数流式加载,显著降低冷启动延迟,无资源闲置费用 |

| 自动批处理 | 动态将请求合并以充分利用GPU算力,实现弹性负载扩展 |

| 平台兼容 | 兼容主流云服务及本地GPU,支持Huggingface、PyTorch框架 |

官方网站提供了详实的性能基准测试数据,证明其在生产环境对比传统推理方案优势显著。

- 无须手写CUDA,对开发者极其友好

- 一行代码完成PyTorch模型加速部署

- 科研与企业可快速从Notebook推向生产

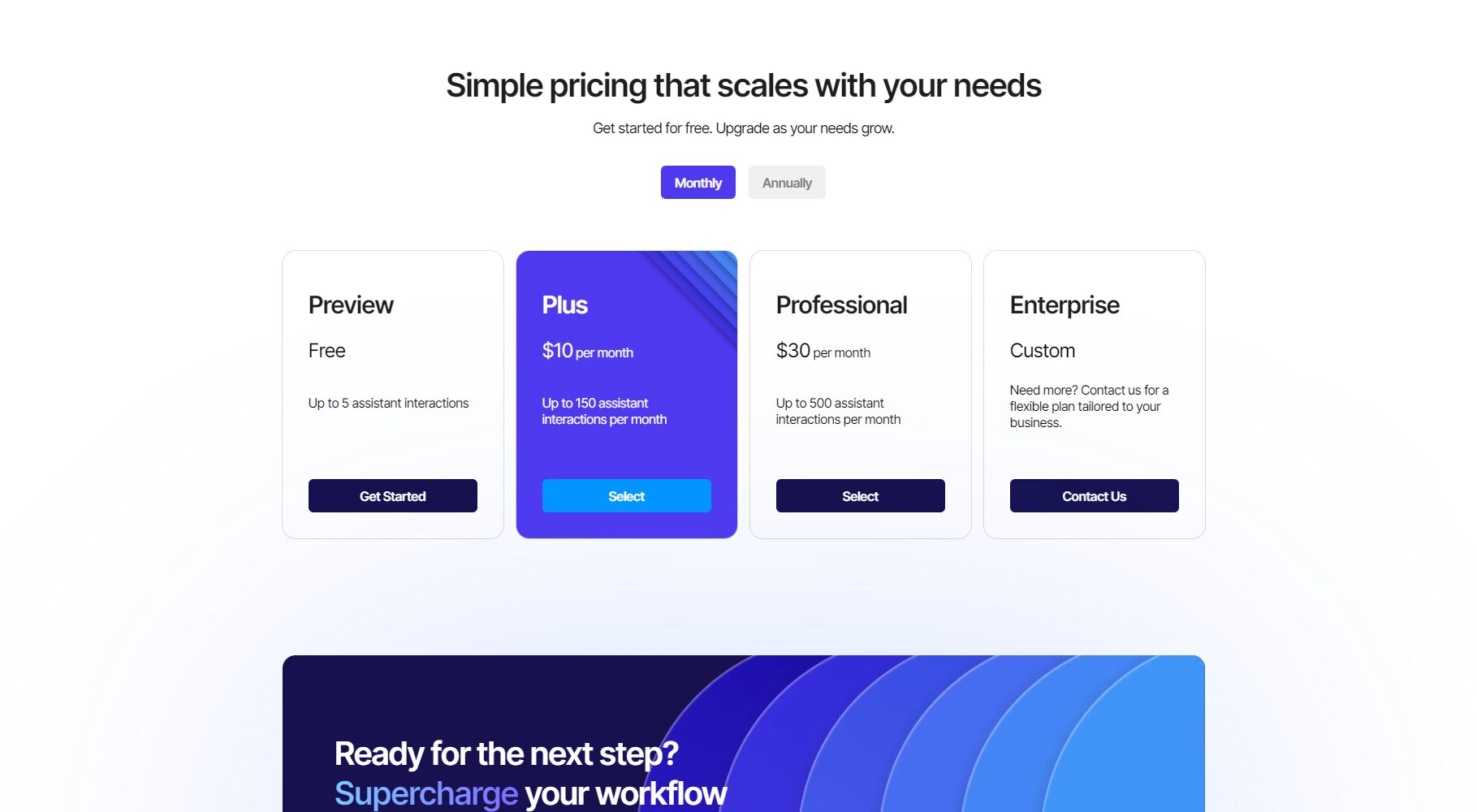

Luminal的价格 & 方案

Luminal目前还在等待名单(Waitlist)模式,主要计费分为按量计费与企业定制两类,采用Serverless Inference的AI效率提升付费模式,仅对实际推理API调用计费,无GPU闲置费用,大大降低企业支出。

| Scheme type | Applicable to | Billing method | 核心特性 | How to obtain |

|---|---|---|---|---|

| Individual/Developer | 学术/个人研发 | 按调用计费 | 免费额度+超出计费,快速部署 | 加入Waitlist |

| 企业/科研团队 | Enterprises/Institutions | 阶梯用量+套餐 | 定制服务,私有云支持 | 联系团队 |

| 开源本地体验 | 开发者/学术 | Free/Open Source | 自行构建试用,社区支持 | GitHub |

如何使用Luminal

Luminal设计极简,将AI模型加速与自动部署流程集合于一体。

- 上传模型——支持上传Huggingface、PyTorch等主流格式模型和权重。

- 一键编译与优化——平台自动分析神经网络并生成GPU代码。

- 获取API端点——立即获得API调用RESTful等主流协议接口。

- 调用/集成——面向科研、产品或内网系统,实现推理批量调用和弹性扩展。

- 监控与统计——实时查看推理速度、调用量、冷启动延迟等关键指标。

# 伪代码演示

import luminal

model = luminal.load('your_model.pt')

endpoint = luminal.deploy(model)

result = endpoint.predict(input_data)

极大降低了工程部署与维护门槛! 更多开发文档见 Luminal GitHub项目。

Luminal的适用人群

- AI科研人员 / 实验室团队:从模型原型到生产部署无缝衔接

- AI开发工程师 / 数据科学家:节省GPU调优和代码工程时间

- 企业级AI主管 / CTO:加速上线与降低云端资源费用

- 初创及中小型公司:低成本享用顶级推理性能

- 数据分析与创新业务团队:大数据AI驱动清洗与处理轻松实现

| Industry Scenarios | 应用描述 |

|---|---|

| 金融风控 | 自动化风控模型动态部署、高并发推理支持 |

| 生物医疗 | 医疗诊断实时处理与大数据分析 |

| Intelligent Customer Service | 大型客服中心NLU模型快速升级 |

| 电子商务 | 商品检索/个性化推荐模型弹性扩容 |

| 科研机构 | 实验模型发布与复现实验推动产业转化 |

Luminal的数据处理能力简介

除了AI模型推理,Luminal也专注于数据处理。例如,针对结构化数据和大型电子表格,平台拥有AI自动清洗、转换和分析能力:

- 支持自然语言数据查询与操作,Prompt自动生成Python脚本

- 可应对TB级别大数据清洗分析

Luminal平台的技术团队及发展愿景

Luminal创始成员曾在Intel、Amazon、Apple等公司带队研发AI算子优化与编译器,获顶级孵化器Y Combinator支持。平台愿景是让每个AI团队不用操心硬件调优,把更多精力用于算法创新与业务落地,加速AI普及和产业化。

Frequently Asked Questions (FAQ)

Luminal如何保证模型加速的兼容性?

平台采用自动算子分析及高层硬件抽象,兼容主流PyTorch、Huggingface框架,CUDA代码适配各主流GPU/云服务,适应未来算力升级。

Serverless部署如何免除冷启动和闲置费用?

Luminal利用智能缓存和流式权重加载,将冷启动延迟降至极低,无须为GPU空闲付费,资源弹性扩缩。

如何申请试用或获取企业方案支持?

开发者可通过官网waitlist申请试用,企业可直接邮件联系Luminal团队定制服务。

Luminal作为当下AI推理和高效数据处理领域的引领者,正驱动AI模型“上云即用”、极简高效新范式。如果你是AI创新者、企业数据主管,抑或希望为开发团队降本增效,Luminal无疑值得持续关注与尝试。未来,随着模型复杂度升级及算力普惠,Luminal将更大程度释放AI生产力,为行业带来更多可能。点击了解更多Luminal资讯

data statistics

Data evaluation

This site's AI-powered navigation is provided by Miao.LuminalAll external links originate from the internet, and their accuracy and completeness are not guaranteed. Furthermore, AI Miao Navigation does not have actual control over the content of these external links. As of 10:14 PM on November 15, 2025, the content on this webpage was compliant and legal. If any content on the webpage becomes illegal in the future, you can directly contact the website administrator for deletion. AI Miao Navigation assumes no responsibility.

Relevant Navigation

iFlytek Documents

Baidu Translate

StableLM

6pen Art

Humata AI

Pic Copilot

ClipDrop Remove Background