Tesla P40 in Detail: How can AI developers leverage the Tesla P40 to improve deep learning training efficiency?

Tesla P40作为NVIDIA专为AI深度学习训练与推理优化的GPU产品,凭借其Pascal架构、24GB大显存和强劲计算能力,成为众多AI开发者、企业和科研机构提升模型训练效率的利器。本文详细解析了P40的架构、性能优势,解析其如何借助CUDA、TensorRT等工具链优化深度学习流程,并结合实际案例与多场景应用,剖析怎样最大化利用P40的算力,从而加速AI创新迭代。

Tesla P40产品亮点与技术核心

1. Tesla P40硬件架构解析

Tesla P40基于NVIDIA Pascal架构,采用16nm工艺,内置3840个CUDA核心,显存达24GB GDDR5。这一配置为大模型训练和高并行计算任务提供强大动力。

| 主要参数 | 详细信息 |

|---|---|

| 架构 | NVIDIA Pascal |

| CUDA核心数 | 3840 |

| 显存 | 24GB GDDR5 |

| 深度学习性能 | 高达47 TOPS (INT8) |

| 单精度浮点性能 | 12 TFLOPS |

| 最大功耗 | 250W (动态功耗管理) |

| 接口 | PCIe 3.0 x16 |

高性能和大容量显存满足深度神经网络、图像识别、NLP等多样场景的需求。

2. 针对深度学习的性能优化

- 批量训练效率大幅提升: 单批次可加载更大Batch,加快参数更新。

- 推理速度暴涨: 高并发低延迟,优适云端服务。

- 并行计算优化: 3840个CUDA核,实现海量并行任务处理。

支持FP16、INT8混合精度,大幅超越传统CPU方案。

3. 节能高效的部署优势

动态能耗管理,支持TDP调节,PCIe直供电简化扩展,降低机房能耗压力。

AI开发者如何利用Tesla P40提升训练效率?

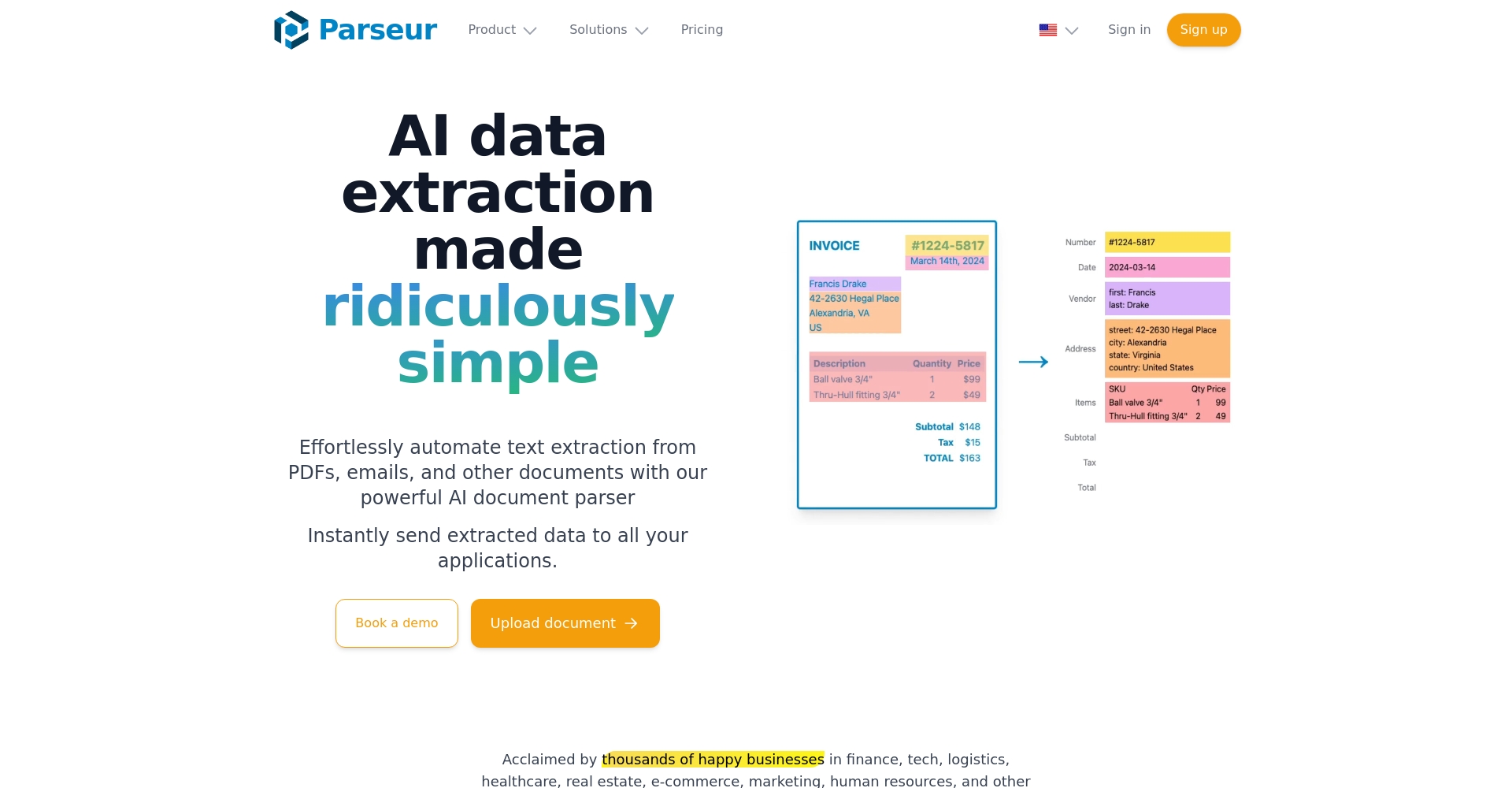

1. 借助TensorRT与CUDA工具链实现极致优化

开发者通过CUDA工具链与TensorRT推理引擎,可为深度学习模型量身打造高效运算流程。推荐工作流:

- 用PyTorch/TensorFlow开发训练模型。

- 启用NVIDIA DALI等数据加载库加快预处理。

- 用TensorRT在P40平台加速模型推理,降低延时。

- 实现NLP、CV、语音AI端到端的GPU加速部署。

详情可访问TensorRT官网。

2. 高频应用场景举例

| 应用领域 | 训练加速表现 | 部署优势 |

|---|---|---|

| 图像识别 | 速度提升20-50倍 | 多模型并发,工程简化 |

| 自然语言处理 | 大规模推理更高效 | 低延迟,适用实时场景 |

| 医疗影像分析 | 大尺寸输入无压力 | 多路协同,提升可用性 |

| 智能推荐系统 | 高效处理百万特征 | 支持增量学习,灵活应变 |

众多知名AI头部企业——如科大讯飞、商汤、百度均大规模部署Tesla P40以承载高负载AI研发任务。

3. 案例解析:讯飞语音云平台极限加速

以科大讯飞为例,其AI云平台利用Tesla P40训练,速度提升超50倍,能耗仅为M40的1/3,溢出体验显著提升。详细报道。

Tesla P40对深度学习开发者的价值与生态支持

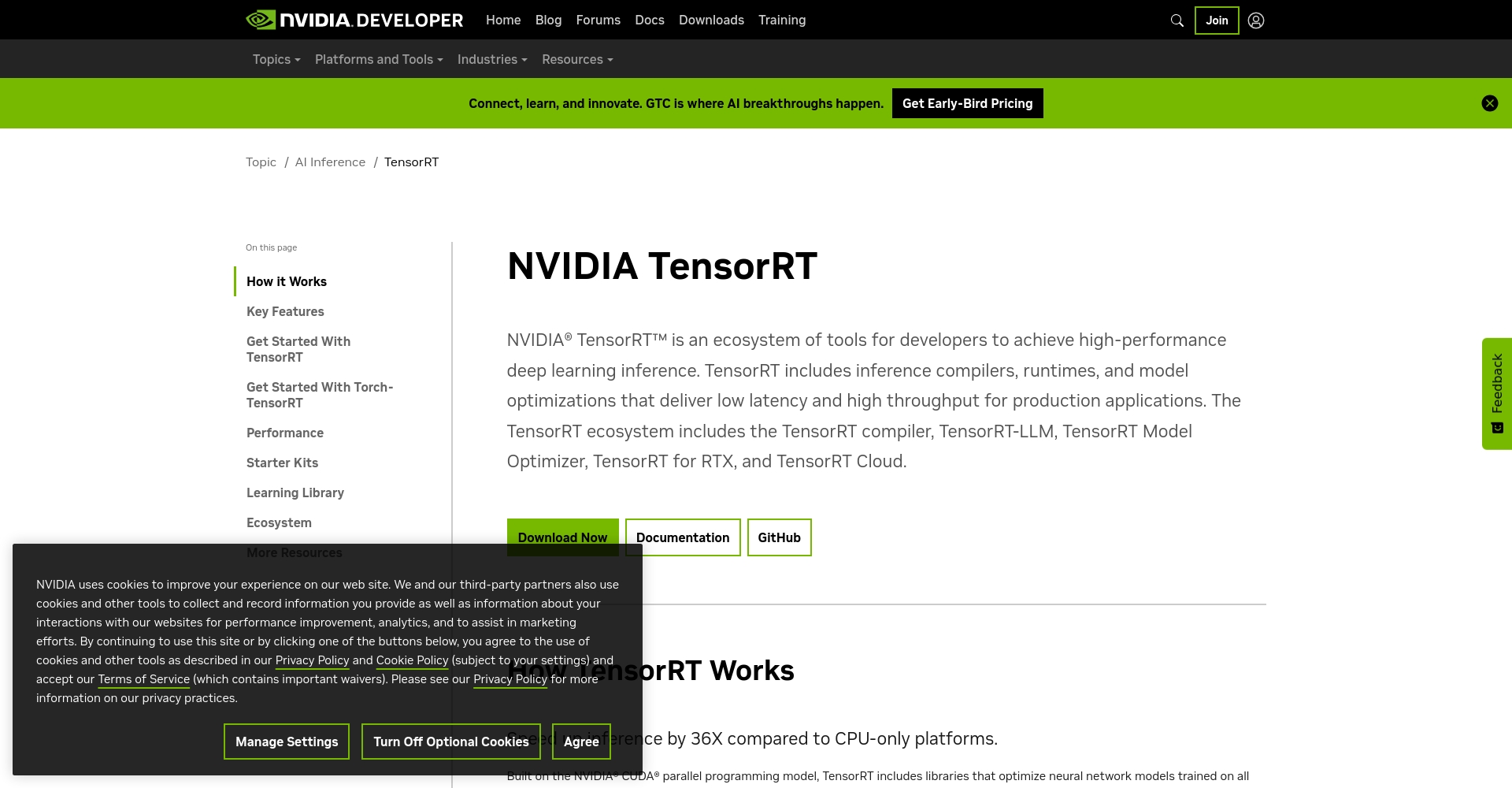

1. 丰富的软件生态与易用工具

- CUDA Toolkit,多语言GPU开发接口;

- cuDNN库,神经网络高效运算API;

- NVIDIA Docker/NGC镜像,一键部署TensorFlow、PyTorch等主流框架;

- 设施部署文档丰富,社区活跃。

开发者平台详见 NVIDIA Developer。

2. Tesla P40助力多GPU分布式训练

分布式通信库NCCL,支持多卡数据/模型/混合并行,适合BERT、GPT等超大型模型场景。

| 分布式方案 | 优势 | Applicable Scenarios |

|---|---|---|

| 数据并行 | 批量加大,加速收敛 | 海量图像/文本 |

| 模型并行 | 大模型拆解多卡协作 | BERT、GPT-3 |

| 混合并行 | 灵活应对多样需求 | 企业大规模部署 |

3. AI开发者实用建议

- 驱动与固件常升级,确保硬件性能最优发挥。

- 推荐用NVIDIA DALI、Triton Inference Server等高效批量推理(Triton Server)。

- 结合Kubernetes和NVIDIA GPU Operator做弹性GPU集群调度。

行业前景与Tesla P40持续价值

AI模型参数级数增长,算力成为创新瓶颈。Tesla P40凭借单卡极致性能与成熟生态,广泛服务于医疗、自动驾驶、智慧城市、机器人等领域,成为企业和机构AI研发的“生产力中枢”。

据Gartner/IDC等数据,2024年Tesla P40依然稳居AI训练主流方案,这归功于其软硬件协同与易用特性。

作为AI硬核训练与推理平台,Tesla P40已成为众多AI开发者缩短模型周期、推动算法落地的关键武器。合理部署与深度挖掘其潜力,将为团队带来持续技术创新。

© Copyright notes

The copyright of the article belongs to the author, please do not reprint without permission.

Related posts

No comments...