Collaborative LLM Tool(Petals)为AI大模型带来革命性的低门槛分布式推理与微调解决方案。用户仅需消费级GPU便可通过P2P网络,协作参与Llama、Mixtral等主流开源大模型的实时推理和微调。无需高昂服务器成本,极低准入门槛,支持丰富开发接口,适合AI开发者、科研者及创新企业试验AIGC应用。Petals完全开源免费,推动了AI算力公益和模型开放创新,但对于商用保障、激励与安全尚在完善中。

Collaborative LLM Tool(Petals):重塑AI大模型的民主化合作新格局

在大语言模型(LLM)主导AI革命的时代,高效、低门槛的分布式模型推理与微调成为AI研究与应用的强烈诉求。Collaborative LLM Tool(Petals)通过协作式LLM的创新机制,让全球开发者用普通GPU即可参与超大规模大模型的推理和训练,为AI产业带来全新范式。本文将从功能、价格、使用方式、适用人群、优势与局限、FAQ等多维度,全面解析这个AI基础设施的重要创新。

什么是Collaborative LLM Tool(Petals)?

Petals由BigScience、Yandex Research等团队推动,是一种BitTorrent式分布式大模型推理与微调平台。用户可用普通GPU通过P2P协作网络参与Llama 3.1、Mixtral、Falcon、BLOOM等超大模型的推理与微调,极大降低AI大模型的使用门槛,把AI能力带入大众。其核心理念为:每台电脑都是虚拟超级算力网络的一员。

Main functions

- 去中心化协作: 通过P2P分布式架构,用户仅加载部分模型参数,剩余由全球网络协作完成。

- 即时高效推理: Llama-2-70B等模型推理速度最高可达6 tokens/sec,支持实时chatbot等场景。

- 开源、灵活接口: 可用PyTorch、Transformers等主流库深度调用,定制采样与微调。

- 节点贡献激励: 任意用户均可通过分享GPU算力加入主网,提升整体容量与算力。

| Functional categories | Key Highlights | Support methods |

|---|---|---|

| 推理协作 | 多人分摊大模型负载 | 分布式P2P网络 |

| 开源模型支持 | Llama/Mixtral/BLOOM/Falcon等 | Transformers |

| 微调定制 | 自定义、增量微调 | API及PyTorch |

| 节点贡献 | GPU算力共享 | 专用python包 |

Price and Plan

- 开源免费: 所有普通用户可接入社区算力网络推理及微调,完全零成本。

- 算力贡献机制: 任何人可无偿贡献GPU加入网络,无金钱奖励(未来或有优先权/激励机制计划)。

- 企业应用: 主要面向开源/研发,商用方案可通过社区议价或官方沟通。

| 用户角色 | cost | Remark |

|---|---|---|

| Regular users | free | 社区P2P主网 |

| 贡献者 | 免费(能源自付) | 算力贡献提升容量 |

| 企业/商业部署 | 议价/社区支持 | 尚无明确付费方案 |

如何使用Collaborative LLM Tool

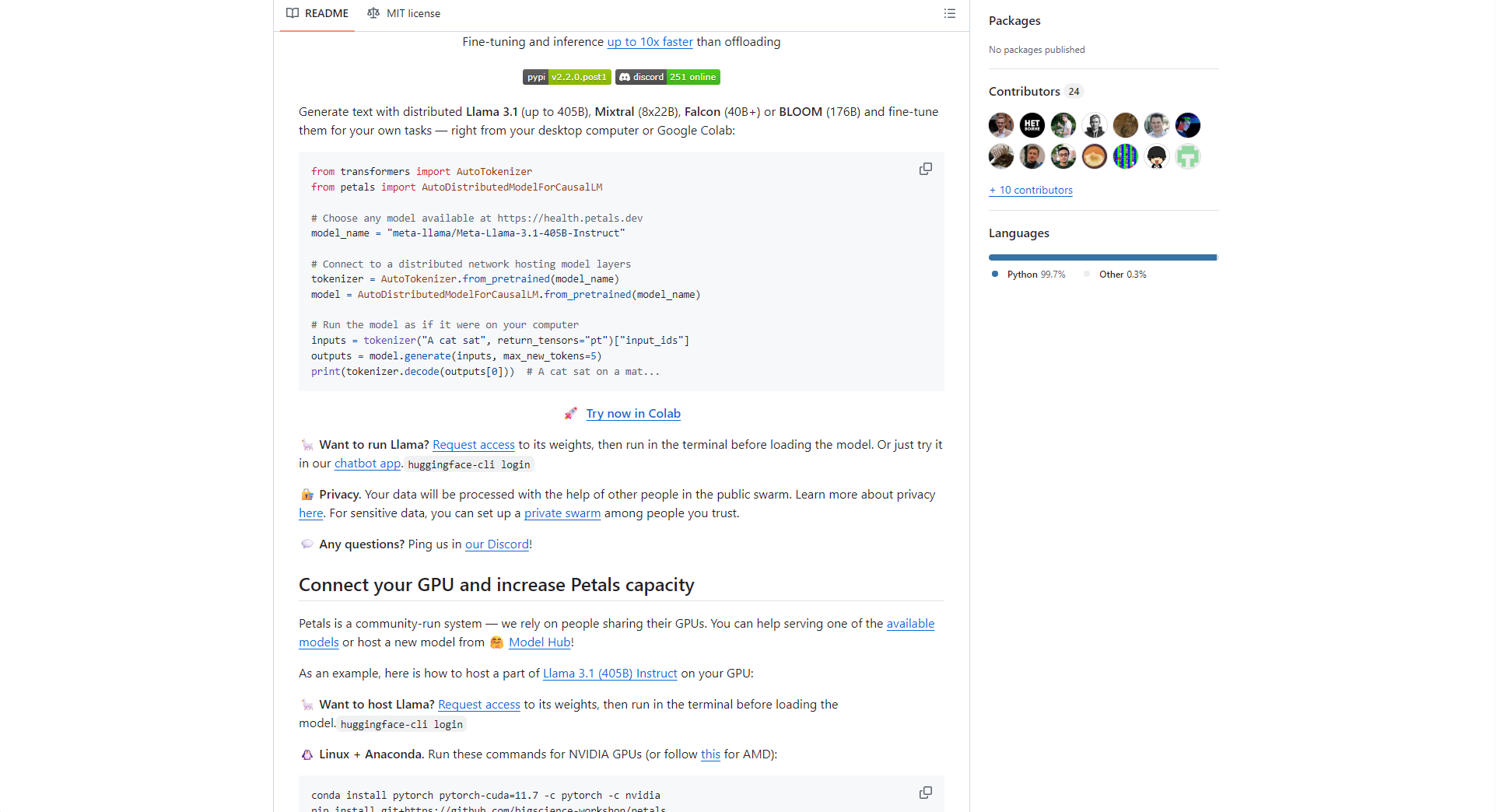

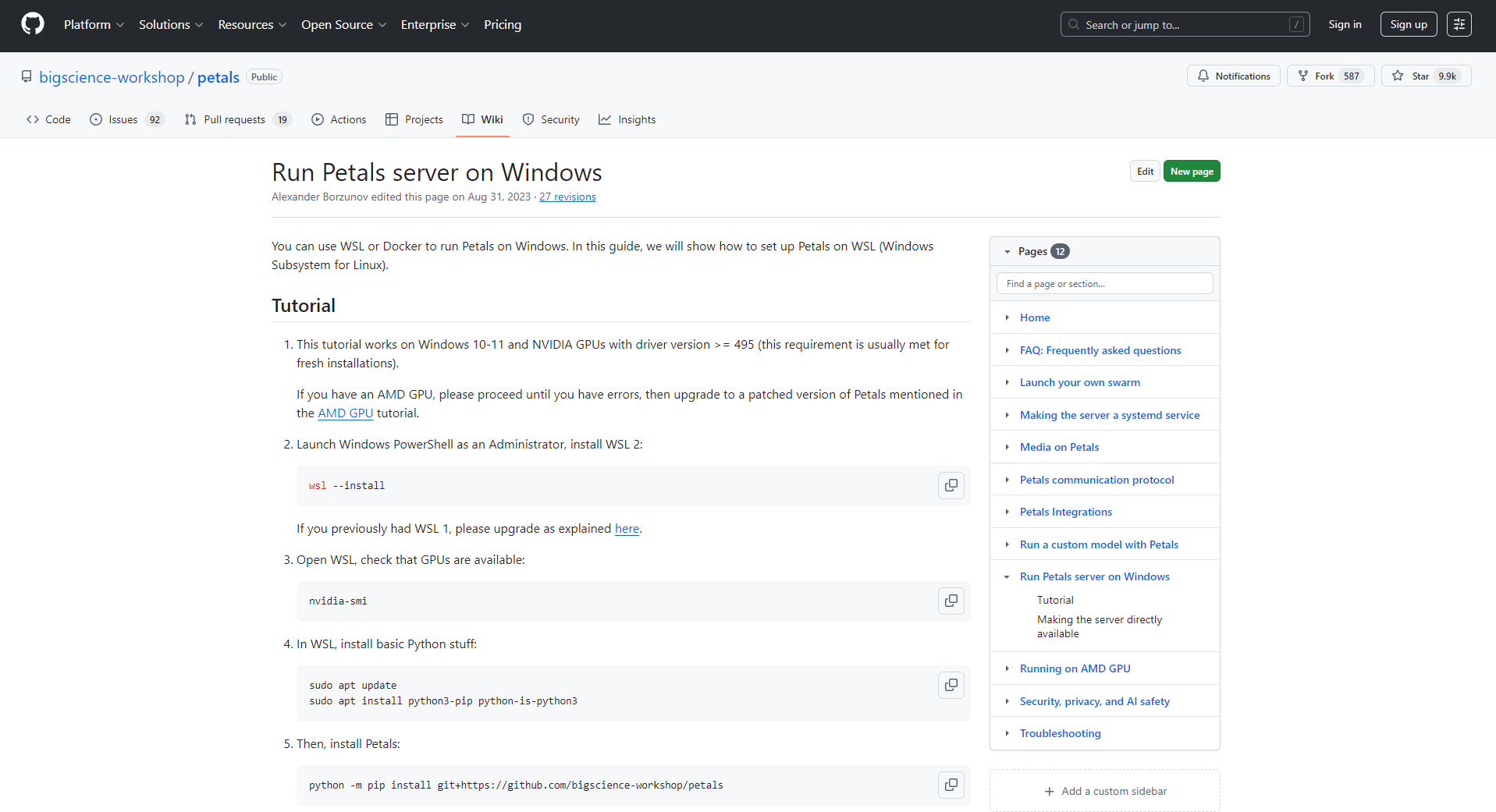

- 环境准备: 仅需Python 3.8+与pip,推荐用Google Colab一键体验。

- 推理客户端使用:

from transformers import AutoTokenizer, pipeline

from petals import AutoDistributedModelForCausalLM

model = AutoDistributedModelForCausalLM.from_pretrained("meta-llama/Meta-Llama-3-70B-Instruct")

tokenizer = AutoTokenizer.from_pretrained("meta-llama/Meta-Llama-3-70B-Instruct")

pipe = pipeline("text-generation", model=model, tokenizer=tokenizer)

pipe("你好,介绍Petals平台的优势:", max_new_tokens=50)- 节点贡献: 运行官方python包,指定托管层数即可参与算力主网。

- 进阶定制: 用API/PyTorch访问模型各层与隐藏状态,支持自定义微调与采样。

- 网络健康监测: 实时主网状况——查看可用模型、节点与速率。

Target audience

- AI研究者与开发者: 用低成本做大模型推理/微调与结构探究。

- 创新企业与初创团队: 快速验证大模型业务场景,无需高昂算力成本。

- 教育场景/AI爱好者: 实训、课程、入门实验及社区算力公益。

- P2P/分布式算力技术爱好者: 探索下一代AI算力网络技术。

| Application directions | 场景实例 | How to use |

|---|---|---|

| NLP应用 | 自动问答、聊天机器人 | 推理与定制微调 |

| Education/Research | 模型原理教学与实验 | 查看中间层/自定义采样 |

| Content generation | 文章、代码生成 | API开发 |

| 科技公益 | 算力捐赠社区 | 节点贡献 |

Advantages and limitations

Core advantages

- 门槛极低: 普通GPU即可用,无需高端服务器。

- 扩展弹性: 节点越多,性能越强。

- 完全开源协作: 支持模型定制、训练与推理,无锁定。

- 环保高效经济: 盘活社会闲置GPU,提升整体算力能效。

潜在局限

- 网络依赖大: 节点失联与波动可能影响性能。

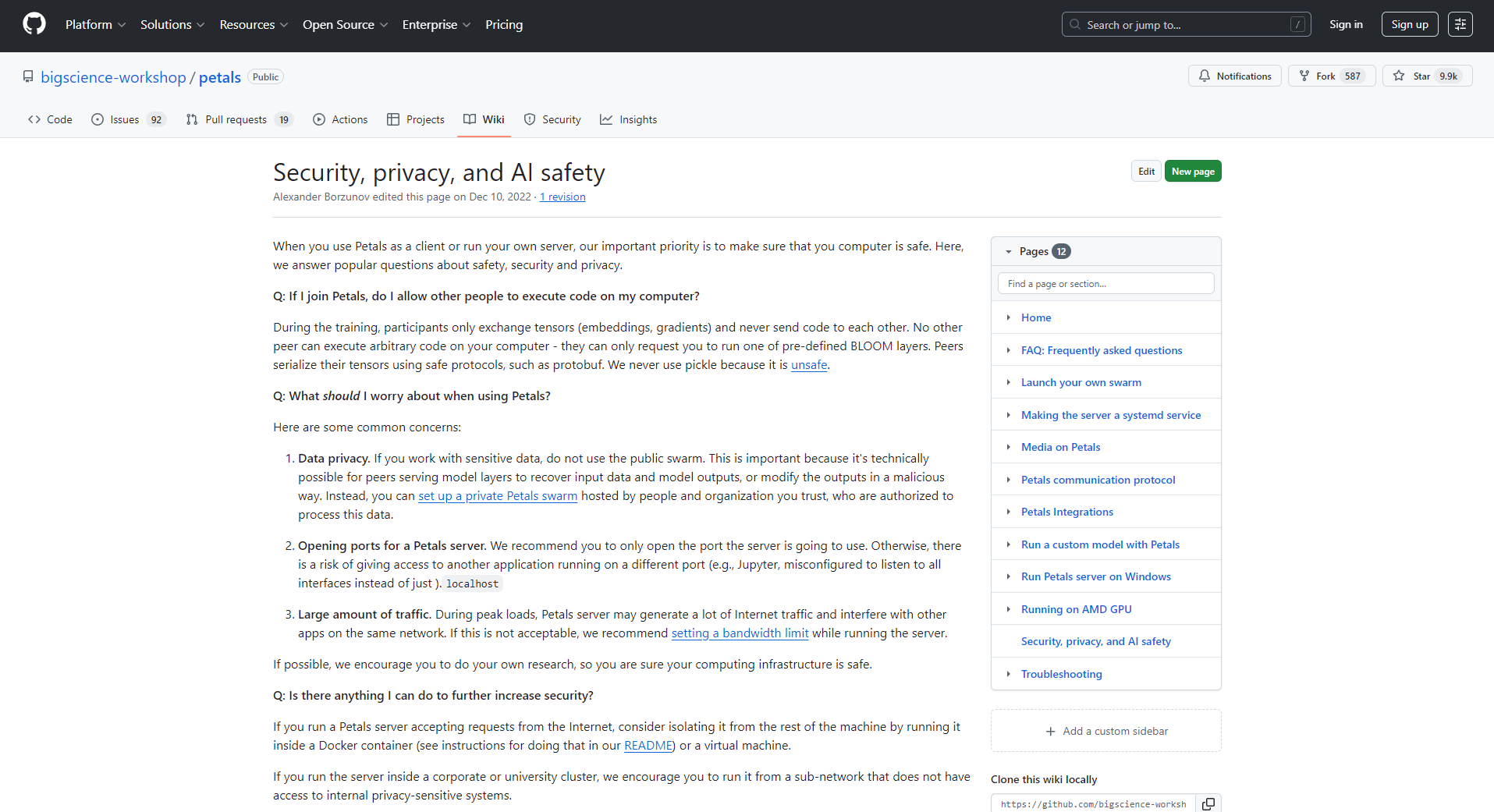

- 数据安全隐私: 需自主评估数据加密与传输风险。

- 商用产品化尚待成熟: 暂无标准SLA或计费机制,激励模式在完善。

架构与部署简述

Petals基于BitTorrent分层P2P模型分布,每节点仅托管部分模型层,数据流经节点进行推理与训练,低配硬件亦可协同大模型AI,极大推动了AI办公工具的全民化普及。

| technical methods | 中心化服务器 | Petals分布式 |

|---|---|---|

| Hardware Requirements | Extremely high | 普通GPU/Colab |

| 单点故障 | 易受限 | 弹性切换 |

| 性能拓展 | limited | 节点越多越强 |

| cost | 高额 | 零门槛/共享 |

发展与社区动态

- 持续支持新一代大模型(如Llama 3)。

- 活跃社区,官方Discord等多渠道活跃交流。

- 技术开源、透明,对学术与产业用户高度开放。

- GitHub project homepage持续更新。

Frequently Asked Questions

- Q:数据隐私和安全如何保证?

A:Petals重视节点隔离与安全,敏感数据建议本地化或加密处理,关注官方隐私动态。 - Q:推理速度和稳定性?

A:普通节点健康期推理速度主观可达4-6 tokens/sec,部分高峰期性能略有波动,建议实时关注主网健康。 - Q:贡献GPU有奖励或风险吗?

A:目前以公益与开源精神为主,官方计划未来出台激励机制,节点运行风险低,按官方教程操作即可。 - Q:能否商用?

A:现以开源社区和科研为主,商用合约和保障请与官方团队联系或持续关注平台动态。

在AI大模型门槛攀升之际,Collaborative LLM Tool(Petals)通过分布式创新设计与开源协作理念,为AI产业带来“人人可参、人人可用”的新模式。它极大推动了AI办公工具(如自动写作、办公自动化、推理与内容生成)的普及和民主化。更多详情请参考Petals官网和GitHub Homepage。

data statistics

Data evaluation

This site's AI-powered navigation is provided by Miao.Collaborative LLM Tool都来源于网络,不保证外部链接的准确性和完整性,同时,对于该外部链接的指向,不由AI 喵导航实际控制,在2026年1月17日 pm6:22收录时,该网页上的内容,都属于合规合法,后期网页的内容如出现违规,可以直接联系网站管理员进行删除,AI 喵导航不承担任何责任。

Relevant Navigation

LongShot

Contents.ai

Civitai

Lightning AI

Rose AI

Texta

Cicada Mirror