本文以新闻报道视角,聚焦AI平台与企业在模型压缩与推理加速上的五大关键技巧:分别是量化(Quantization)、剪枝(Pruning)、知识蒸馏、轻量结构设计、编译器与硬件加速。内容覆盖主流方法原理、工具选型、业界最佳实践与应用案例,旨在帮助开发者高效节省算力资源、优化模型部署成本,全面提升AI落地普及率。文章适合技术团队与AI产品工程师掌握前沿模型优化思路,并提供开发实用指南与资源推荐。

AI模型压缩与加速5大技巧总览

| 技巧名称 | 运作原理 | 适用场景 | 代表工具/平台 | 可配合服务 | 典型效果 |

|---|---|---|---|---|---|

| 1. 量化(Quantization) | 32/16位权重转为更低位(8/4/2位整数),大幅减少运算与存储 | 覆盖多数NLP、CV模型,LLM推理部署 | HuggingFace、ONNX、TensorRT、vLLM | AWS SageMaker、Azure ML等 | 2~16倍压缩,推理速度提升10X |

| 2. 剪枝(Pruning) | 移除不重要的权重和连接,精简结构 | 有大量冗余的深度模型 | Torch Pruning、SparseGPT、TF Optimization | 主流云ML平台 | 1.5~10倍压缩,加速显著 |

| 3. 知识蒸馏 | 用大模型“教师”训练小模型 | 需压缩型任务、小设备部署 | DistilBERT、MiniLM、MobileNet | HuggingFace、SageMaker等 | 体积10~30%,效能达80~95% |

| 4. 轻量结构设计 | 高效模型架构,极致精简卷积/通道 | 手机/IoT/边缘部署 | MobileNet、EfficientNet、SqueezeNet | TF Lite、PyTorch Mobile | 缩至1/5甚至1/10,低功耗 |

| 5. 编译器与硬件加速 | 将模型专属优化为硬件高效指令 | 云端API、边缘AI、极致并发 | TensorRT、TVM、ONNX Runtime、vLLM | 云平台GPU/TPU/FPGA | 加速数倍至10倍以上 |

量化(Quantization):压缩与加速的首选方案

技术原理解读

量化通过将32/16位浮点权重替换为更低精度整数(8/4/2位),大幅缩减模型体积,加快推理速度,尤其适合高并发与资源受限场景。

- 训练后量化(PTQ):适合泛用模型,快速部署,部分精度损失

- 量化感知训练(QAT):训练阶段量化,适合精度要求高场合

主流工具 & 平台

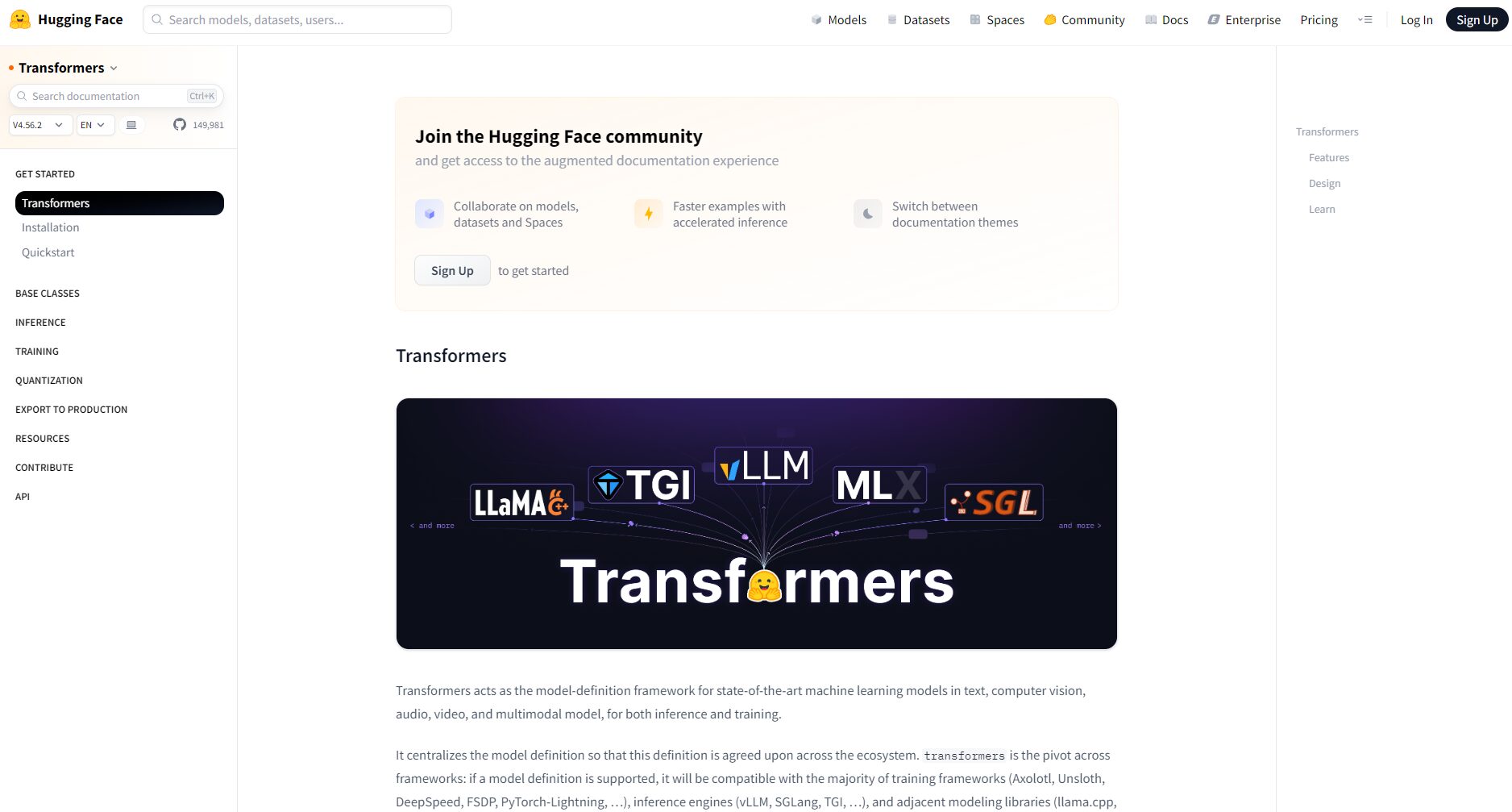

- HuggingFace Transformers:支持BitsAndBytes、Optimum自动量化,配合QAT/PTQ。

- ONNX Runtime:全自动量化导出,适配主流框架和硬件。

- TensorRT:适合NVIDIA生态,支持FP16/INT8/INT4最优加速。

- vLLM:专为大模型推理优化,支持多种量化格式。

- 各大云平台如AWS SageMaker、Google Vertex AI均一键兼容。

行业应用案例

- 智能手机语音助手与影像美颜模型,int8量化大幅延长电池寿命。

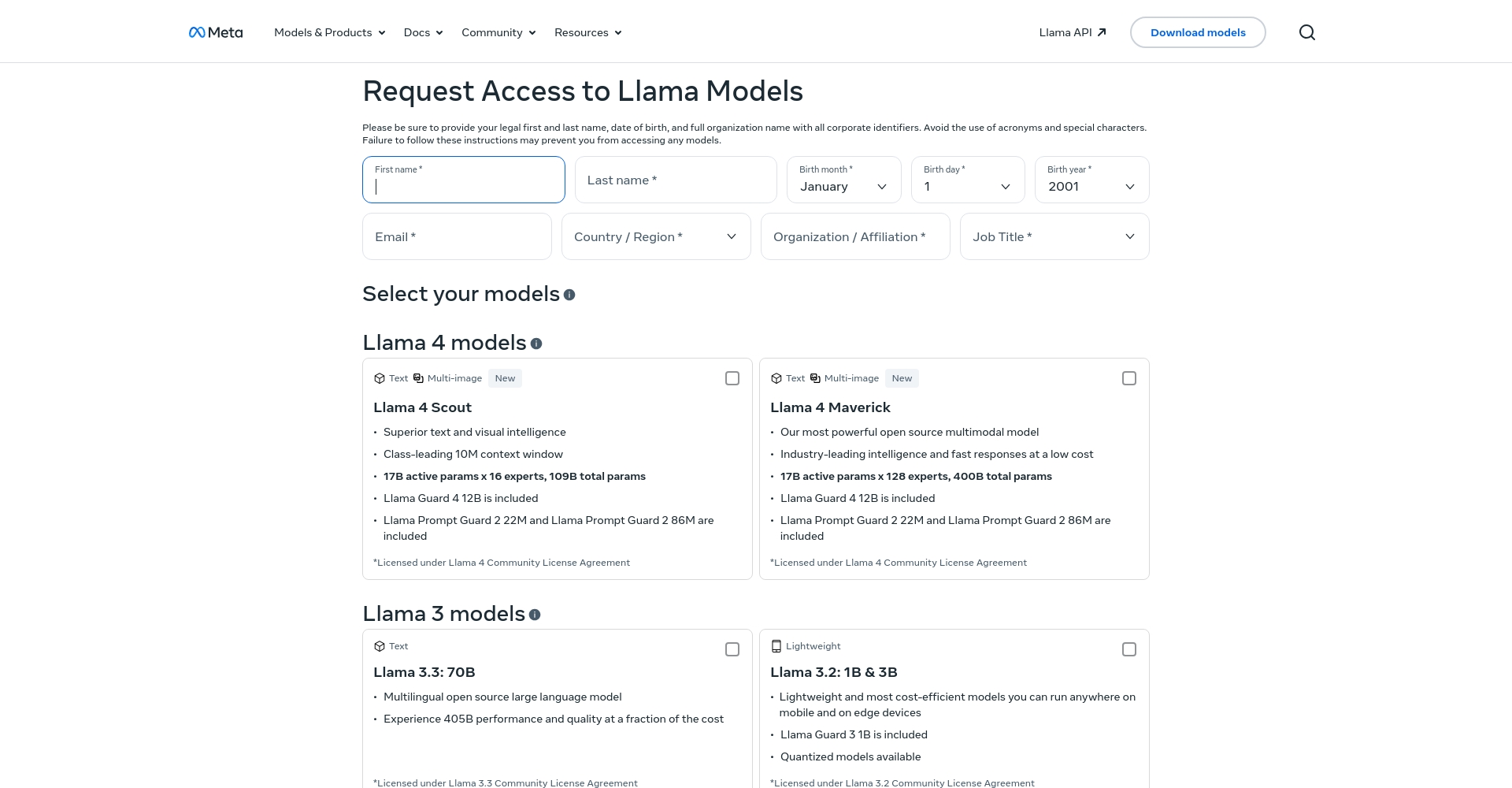

- Meta Llama、OpenAI GPT等云端推理自动集成低比特量化,降低成本。

- 主流AI社区(如Stable Diffusion)权重提供4/2 bit版本,便于多端推理。

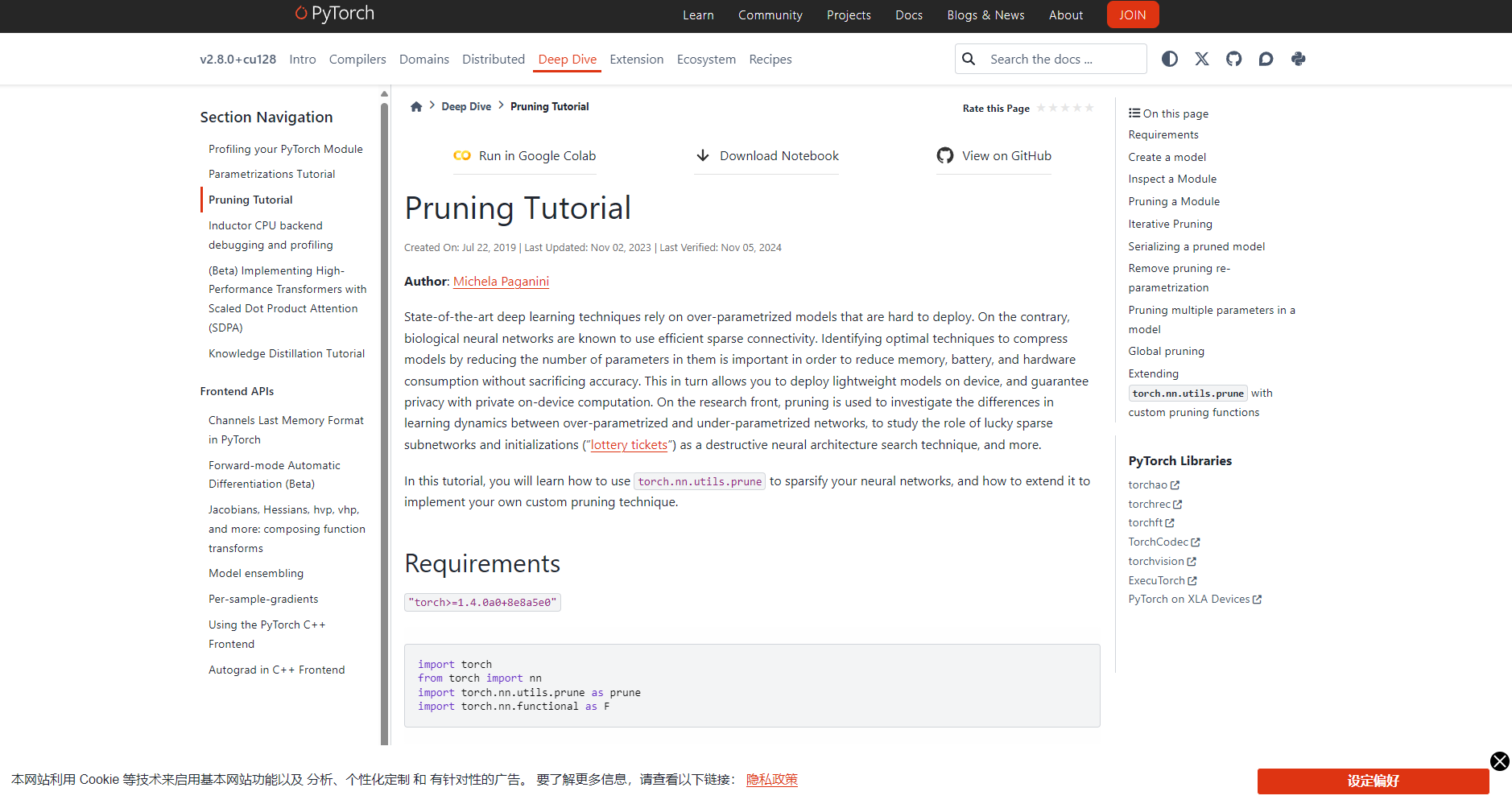

剪枝(Pruning):让网络变“瘦”提速核心推理

技术原理

剪枝通过移除多余/低贡献权重,只保留核心参数,支撑极简高效模型。有非结构化(按权重)和结构化(按通道/层)方式,剪枝后需微调修正损失。

工具案例

- PyTorch Pruning系列、TensorFlow Model Optimization、SparseGPT高效大模型极剪框架。

- 各大云平台均支持任务化集成。

应用举例

- OpenAI、Meta通过结构化剪枝,LLM参数量压缩一半。

- AI企业常用model slimming,嵌入轻终端。

知识蒸馏:大带小压缩利器

核心理念

通过大模型为“老师”、小模型为“学生”,传递行为与知识,轻量网络仅用少量参数就能逼近原模型主要功能,适合对延迟和硬件敏感的场合。

主流模型与商业生态

| 模型 | 特性/用途 | 支持工具 |

|---|---|---|

| DistilBERT | 压缩BERT体积到40%+,主流NLP蒸馏代表 | HuggingFace等 |

| MiniLM | 体积小性能高 | 各类开源工具 |

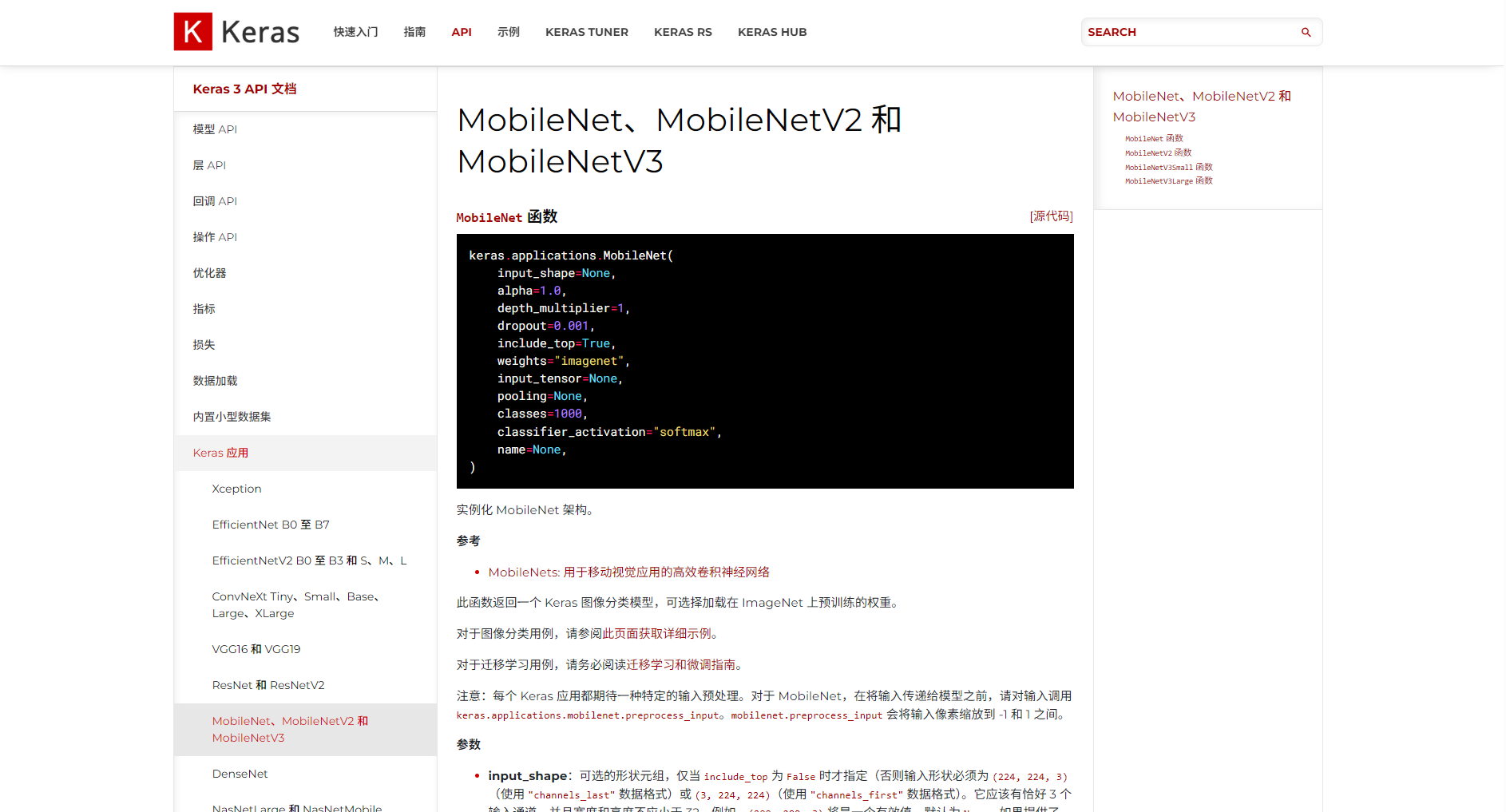

| MobileNet/SqueezeNet | 轻结构与蒸馏并用,手机端优选 | TF Lite、PyTorch Mobile |

应用场景

- 语音机器人、翻译API用小模型超低延迟在线推理

- 嵌入式生物识别、表情分析轻量版模型快速上线

轻量结构设计:为终端而生的AI工程

关键技术点

- 轻量卷积结构设计(如分组卷积、通道压缩)

- 减少层数、压缩核尺寸,提高运算效率。

热门架构与工具

| 架构 | 特性 | 工具支持 | 适用场合 |

|---|---|---|---|

| MobileNetV2/V3 | 深度可分离卷积,低功耗 | TF Lite、PyTorch Mobile | 移动端/IoT |

| EfficientNet | 复合缩放,通用性强 | 主流API | 嵌入式部署 |

| SqueezeNet | 极窄fire模块 | EdgeML | 边缘AI |

成效举例

- 轻量模型仅需1G RAM可独立推理,达到90%+大模型水准。

编译器优化&硬件加速:让推理“飞起来”

核心原理

高阶编译器如TensorRT/XLA/TVM将模型运算转译为本地硬件极致优化指令,极大提升吞吐与并发性能。ONNX标准便于多平台兼容。

主流适用场景

- 企业级API需超高并发低延迟

- 自动驾驶/IoT/工控实时AI推理

- 云服务弹性部署GPU/FPGA/NPU

主流方案与优势

| 方案 | 优势 | 平台/硬件 |

|---|---|---|

| TensorRT | GPU自适应优化 | NVIDIA家族 |

| ONNX Runtime | 广泛平台融合 | CPU/GPU/FPGA/NPU |

| TVM | 自定义图优化 | 全开源支持 |

| vLLM/Triton | 分布式高效推理 | 大规模云端部署 |

量化压缩未来趋势与开发指引

- 极低位(1位/1.58 bit)量化正走向实用化,BinNet等模型极致节省资源。

- 剪枝+量化+熵编码混合,进一步提升端到端效率(AlexNet可压缩至原始3%体积)。

- 基于AutoML和端到端流水线,开发门槛持续降低,主流云平台均已支持自动量化、剪枝与蒸馏一体化部署。

开发者实战指南&进阶资源

- 选择场景适合的压缩方法,手机/IoT优先量化与轻量结构,大模型API则结合编译器、剪枝及多重压缩。

- 利用HuggingFace Optimum、ONNX Quantization等工具反复压缩与推理评估,确保精度均衡。

- 通过AWS SageMaker等云平台融合集成功能,提高交付效率,保持工具链与格式的领先性。

- 关注vLLM、OpenVINO等最新高效推理与分布式量化工具,快速布局新一代AI产品。

参考入口:HuggingFace官方量化指南、ONNX官方量化文档。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...