基于人类反馈的强化学习(RLHF)成为2025年AI领域大模型训练和智能升级中不可或缺的核心技术。文章全面梳理RLHF的基础原理、与传统RL的区别、关键训练流程及主流应用工具,深入剖析数据瓶颈、奖励模型偏差、算力门槛等技术挑战,并重点跟进HybridFlow并行训练、COBRA共识机制、个性化RLHF等2025年领域最新突破。展望未来,RLHF正驱动AI向更安全、可控与多元价值对齐转型,是AI进化“懂你”的必经之路。

RLHF基础知识与技术原理

RLHF的定义和核心流程

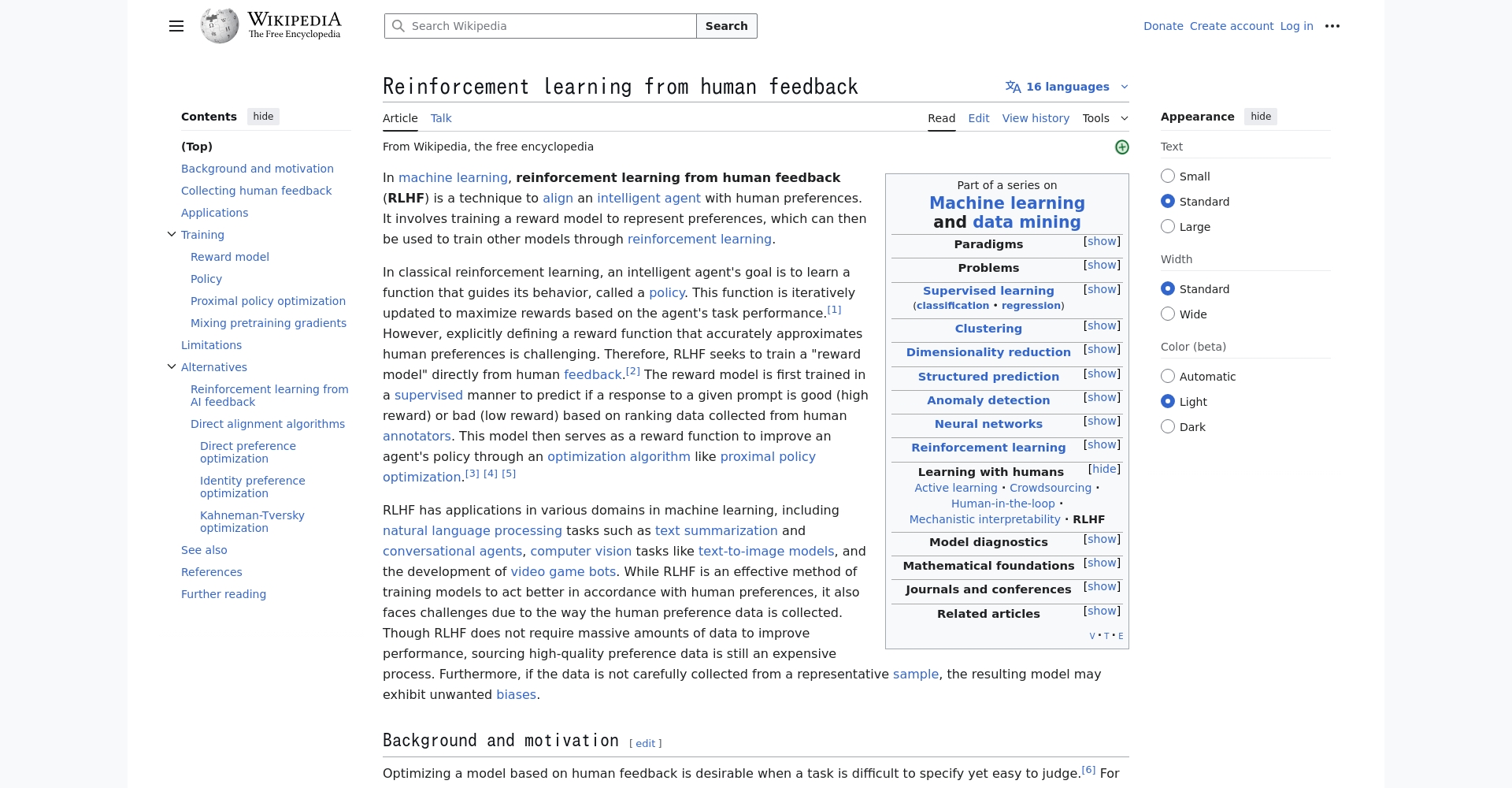

RLHF(基于人类反馈的强化学习)融合了人类评价机制与强化学习算法,实现AI决策对人类期望的高度对齐。它包括预训练、奖励模型训练、强化学习优化等典型环节,是推动ChatGPT、Gemini等生成式AI大模型落地的关键驱动力。

RLHF与传统强化学习差异点

| 对比维度 | 传统强化学习(RL) | RLHF |

|---|---|---|

| 奖励信号 | 环境设定、自动数值 | 来自人类评分/偏好 |

| 目标 | 最大化环境奖励 | 最大化“人类主观偏好” |

| 对齐能力 | 难以捕捉人类复杂需求 | 可对齐人类价值观 |

| 易受欺骗性 | 奖励黑客问题严重 | 加强监管可降风险 |

RLHF有效弥补了传统RL难对齐人类复杂偏好的短板,推动AI更贴合实际人类意图。

RLHF在AI系统与大模型训练中的应用

典型训练流程与应用平台

- 人类标注与采集:高质量人工评分输出数据。

- 奖励模型构建:排序、成对比较训练奖励网络。

- RL优化:用PPO/DPO等引导人偏好。

主流RLHF平台包含:

- OpenAI ChatGPT(强对齐落地)

- DeepSeek(冷启动与高效训练)

- Perle.ai(自动化标注)

- HybridFlow(大规模并行训练)

技术挑战分析

- 高质量标注数据稀缺:人工成本高、主观因素多、易带偏见。

- 奖励黑客与基础能力退化现象:模型优化偏离实际期望。

- 海量算力与长周期训练:初创团队门槛高。

详解见CSDN前沿专栏。

2025年RLHF关键技术突破

| 研究方向 | 关键方法 | 应用成效 |

|---|---|---|

| 奖励模型优化 | 对比训练、偏好损失 | 加快训练收敛、提升有效性 |

| 高并行训练框架 | HybridFlow/流水线解耦 | 吞吐量提升1.5-20倍 |

| COBRA共识机制 | 动态聚合过滤异常 | 奖励准确度提升30~40% |

| 分段奖励机制 | 片段切分+归一化 | 优化速度与连贯性大幅提升 |

| 个性化训练 | Shared LoRA低秩适应 | 垂直场景个性化表现优异 |

| 合成数据结合专家标注 | 自动工具+人工抽查 | 数据保真提升60% |

详细改进方向解读

- 奖励模型高方差训练带来更快优化收敛,策略算法更鲁棒。

- HybridFlow以细粒度流水线并行极大提升训练效率。

- COBRA共识有效防止恶意与异常反馈污染模型奖励。

- 片段奖励与归一化让文本持续优化提升。

- Shared LoRA适配用户偏好,微样本场景效果提升。

- 合成数据+专家标注,显著缓解数据瓶颈。

RLHF技术融合与2025年发展趋势

| 改进方向 | 技术点 | 代表案例 |

|---|---|---|

| 数据标注 | 半自动化、多元化团队 | Perle.ai、Synthetic Data |

| 奖励优化 | 多任务对比、策略改进 | COBRA、HybridFlow |

| 训练效率 | 流水线/并行/冷启动 | DeepSeek、RLHFuse |

| 评测体系 | 偏好代理评估 | Stanford PPE |

| 个性化 | Shared LoRA | 医疗/金融/法律等定制 |

行业应用与未来展望

- 开源社区推动RLHF普及(DeepSeek,RLHFuse等)

- 学术创新突破(普林斯顿、港大混合流训练等)

- 产业级落地:OpenAI、Google、字节跳动构建精细链路

2025年热点聚焦于多模态RLHF(视觉、语音)、联邦隐私保护RLHF融合,彰显AI伦理、安全、个性化等多元价值。RLHF已是训练链路中不可或缺的动力引擎。建议关注 Coursera RLHF课程 及知名开源项目,把握AI新浪潮!

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...