本文解析了“蝴蝶效应”在AI决策领域中的实际影响,通过医疗、金融与内容审核三大领域案例,揭示了微小输入变动如何引发模型输出巨变,可能带来的风险及相应的规避建议。

介绍了蝴蝶效应的定义,并梳理AI系统为何对此如此敏感,从数据规范、模型可解释性、鲁棒性测试等角度,给出系统性的防范方法与操作建议。帮助企业和开发者全面理解这一现象,并提出有效防范对策。

什么是“蝴蝶效应”及其在AI决策中的作用?

“蝴蝶效应”,源自混沌理论,形容系统中微小的初始变化能带来巨大的结果差异。在AI领域,这意味着一个看似微不足道的输入变动,可能导致AI模型输出完全不同的结论。随着AI工具(如OpenAI ChatGPT、Google Gemini)广泛应用于医疗、金融、交通等多个决策领域,复杂算法背后的“蝴蝶效应”也愈发引人关注。

蝴蝶效应影响AI决策的实际案例解析

案例一:医疗诊断系统中的细微数据扰动

在2019年的一项知名医学AI研究中,研究人员发现,医疗影像AI辅助诊断系统仅因像素级的微小变动,诊断结果可出现大幅波动。

例如,在胸部X射线影像中加入极其轻微的噪声,就可能导致AI将本来健康的病人错误诊断为肺部异常。

- 对患者安全构成威胁:误诊可能造成误治、拖延治疗。

- 医疗责任归属难以厘清:医生是否可以信赖AI工具的每一个细节?

相关AI工具:IBM Watson Health、Google Cloud Healthcare AI

| 微小变化 | 数据预处理方式 | 诊断结果差异 |

|---|---|---|

| X光像素增减1% | 图像归一处理 | 正常→疑似结节 |

| 病人信息拼写错误 | 词嵌入编码 | 无风险→高风险(如吸烟史) |

| 随机噪声注入 | 图像增强算法 | 暂无病变→疑似异常 |

案例二:金融信贷评分中的输入波动

世界各大金融机构依赖AI模型进行信贷评级和审批。

据麻省理工学院(MIT)2022年的报告,信贷AI只要输入特征中某项数据(如职业描述)进行细微编辑(如增加或减少一个词),就可能引发模型信用得分大幅波动。

- 客户权益受损:风险评估过高导致贷款被拒或利率升高。

- 合规风险:难以追踪AI决策逻辑,不利于金融监管。

相关AI工具:FICO Score AI系统、Zest AI信贷决策

| 输入变化 | 模型处理机制 | 信用评级波动 |

|---|---|---|

| 职业由“教师”到“初中教师” | 词嵌入及职业匹配 | 评分下调3分 |

| 地址拼写格式变化 | 地域风险权重 | 部分区域利率上调 |

| 月收入输入括号 | 字符串标准化失败 | 工资识别为异常停止审核 |

案例三:舆情分析与内容审核的表述细微调整

在内容审核与网络舆情监测领域,AI模型需快速判断内容是否违规。

根据腾讯优图实验室2023年的测试,仅一个标点或表述顺序的调整,模型对同一条信息的违规预测概率就可能相差15%以上。

- 平台误判、误封账号:正常用户受到不公正处罚。

- 虚假舆论扩散防控漏洞:恶意操作者利用AI机制漏洞绕过检测。

相关AI工具:腾讯优图NLP内容审核、百度内容安全API

| 文本变动 | 审核模型响应 | 结论差异 |

|---|---|---|

| “这是非法集会!” | 判定为违规 | 内容封禁 |

| “非法集会吧?”(加问号) | 判定为不违规 | 内容通过 |

| 句子拆分次序调整 | 舆情情感分数大幅变化 | 热点监控优先级调整 |

AI决策中蝴蝶效应的技术成因与风险

为什么AI模型对“蝴蝶效应”如此敏感?

- 深度神经网络的非线性:小输入可通过多层叠加,被放大为输出的大波动。

- 黑箱模型不可解释性:难以追踪内部决策链路,增加了不可预知性。

- 数据分布脆弱:训练数据中的偏差、小样本极易造成模型对微小变化过敏。

- 输入规范化标准不一:不同系统输入预处理细节差异,导致输出差异。

| 风险类别 | 潜在后果 | 影响领域 |

|---|---|---|

| 误判/漏判 | 损失公信力、法律争议 | 金融、司法、内容审核 |

| 难以追责 | 监管盲区、用户投诉 | 所有自动决策型应用 |

| 操纵利用漏洞 | 被黑灰产或竞争对手利用 | 舆情、金融、广告投放 |

| 信任下滑 | 客户转向传统人工复查 | 医疗、智能问答、教育等 |

如何规避或降低AI决策中蝴蝶效应的风险?

明确输入输出格式与数据规范

- 通过严格输入模板、字段校验,减少非结构化输入变异。

- 应用如OpenAI Function Calling等功能,规范API接口调用输入输出。

多模型交叉验证与解释性增强

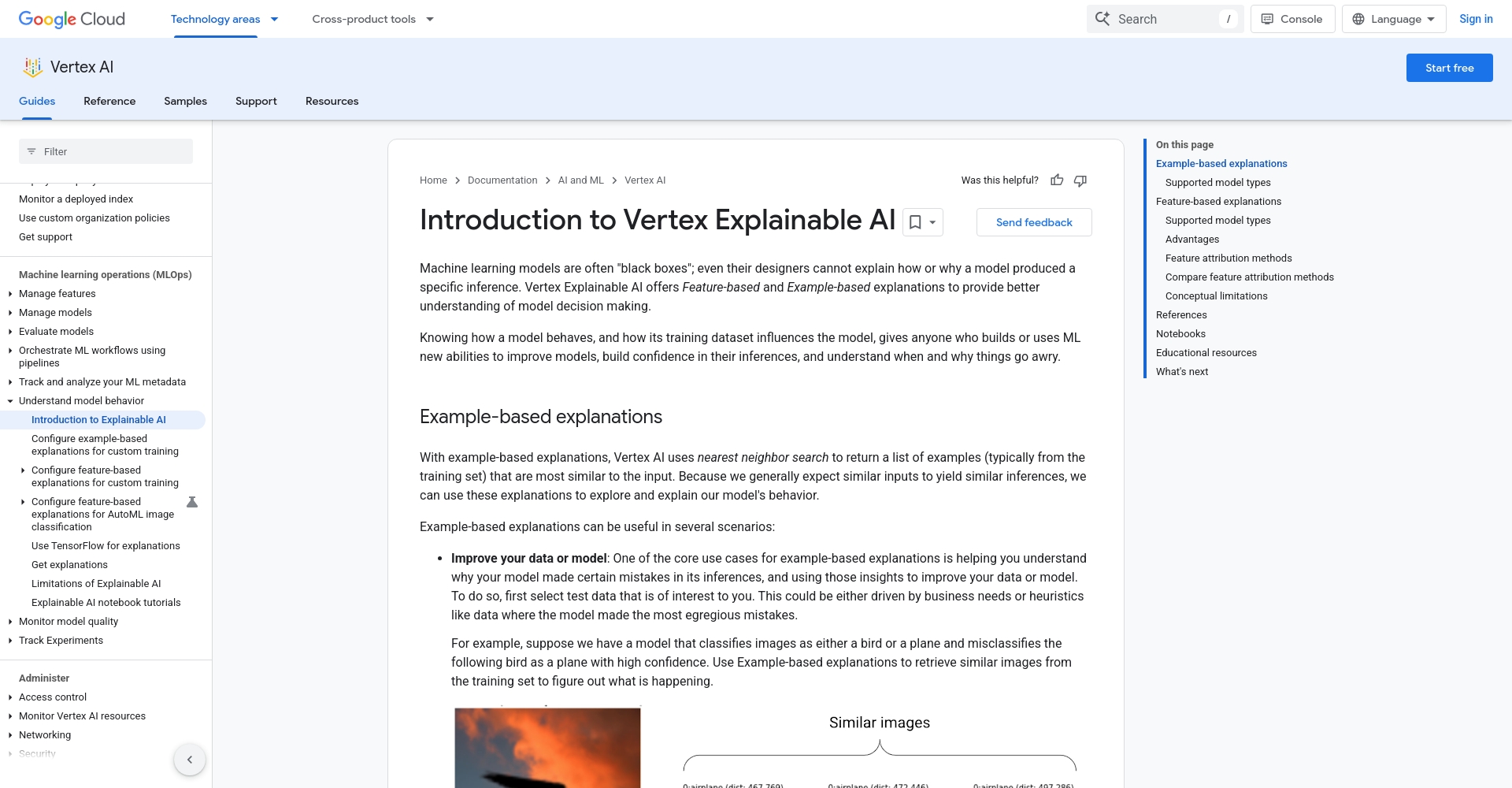

- 可结合Google Explainable AI等服务,通过解释器显示模型为何做出某决定,以便及时发现和校正异常响应。

圖/可解释人工智能展示 - 增设“复核模型”,对关键结果进行人工或其他模型的交叉复核。

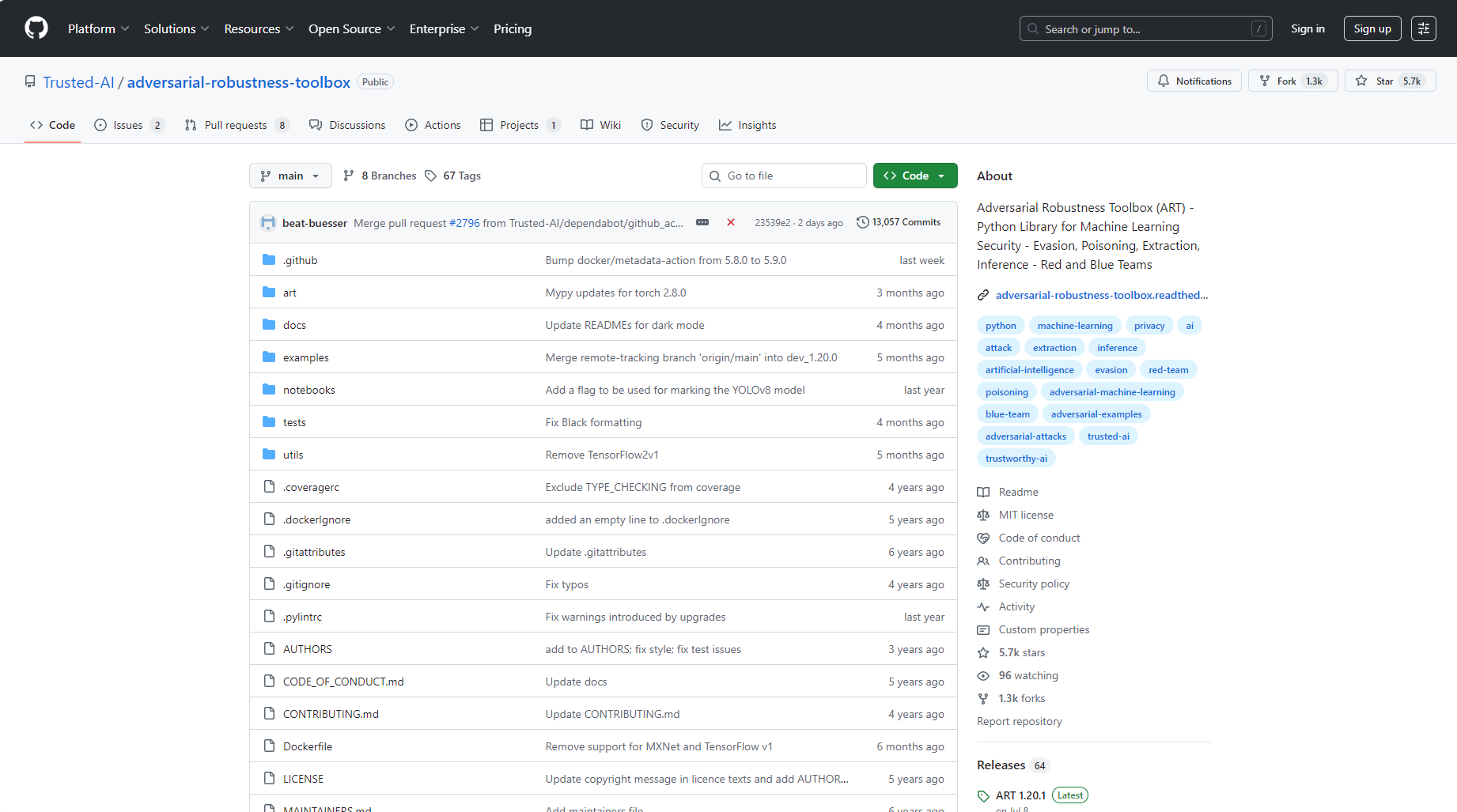

增强对抗性鲁棒性测试

- 利用如IBM Adversarial Robustness Toolbox等开源工具,定期对AI模型实施扰动测试,查找敏感输入点。

| 措施 | 说明 |

|---|---|

| 多样化输入情形测试 | 测试极端和边界案例,完善数据覆盖 |

| 明确规范与模板 | 所有输入输出强制要求模板、审批规范 |

| 加强模型解释与透明度 | 推广可解释AI、反馈机制 |

| 双重系统/多重判定机制 | 重要决策用不同算法/模型复核 |

| 持续风险监控与日志追踪 | 对每次决策过程详细记录,便于追溯与优化 |

| 制定异常自报/人工介入机制 | 发现异常时手动介入,及时补救 |

| 定期更新与对抗性训练 | 持续优化模型对“蝴蝶效应”式干扰的鲁棒性 |

在这个由AI驱动的时代,蝴蝶效应在自动决策领域的影响不容小觑。

只需输入一个停顿、一处拼写错误、一个不经意的格式变动,系统判断就可能天差地别。企业和开发者只有透过严格数据管理、多重验证与风险监控手段,才能真正驾驭AI,防止微小变动演变为决策灾难。随着技术进步,理解与预防数字世界的“蝴蝶效应”将成为AI落地应用的新常态。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...