遷移學習(transfer learning)正在改變AI開發方式,新手利用遷移學習可節省資料資源、加速原型迭代,即便僅有少量樣本也能優化模型效果。文章詳細介紹遷移學習基礎、主流方法、實踐流程與工具平台,輔以迷思解析、常見Q&A與未來展望,協助AI初學者0到1掌握遷移學習理論與實戰。

遷移學習(Transfer Learning)為何成為AI領域新寵兒?

隨著人工智慧(AI)模型規模日益龐大,數據和運算成本不斷攀升,讓AI開發變得越來越依賴資源。遷移學習(Transfer Learning)以其「站在巨人肩膀上」的思路,透過復用已有模型知識,大幅降低了新任務下開發難度。本篇將全面揭秘新手小白如何快速用遷移學習優化AI模型表現,助力你的AI實踐之路!

遷移學習基礎科普

什麼是遷移學習?

遷移學習(Transfer Learning)指將針對某一任務或資料集已訓練好的模型參數和知識,遷移、應用到新任務上,從而加快新模型的訓練、減少資料需求並提升表現。例如利用ImageNet上訓練的ResNet,輕鬆應用在醫學影像等小資料場景。

為什麼要用遷移學習?

- 顯著節省數據與運算資源(無需自訓練大模型)

- 更快迭代產品原型,縮短研發週期

- 小數據集表現優秀,適合冷門或資料稀缺任務

AI產業主流遷移學習場景

| 典型項目 | 益處 | 適合人群 |

|---|---|---|

| 影像分類 | 復用大模型特徵 | 資料工程師、開發者 |

| 文本情緒分析 | 微調NLP大模型 | 內容審核、產品初學者 |

| 聲音/視訊識別 | 跨模態遷移 | 媒體AI工程師、新媒體人 |

遷移學習主要方法及新手實現流程

遷移學習的主流技術路線

微調(Fine-tuning)

- 定義:保留預訓練大部分權重,僅輸出頭等部分參數訓練。

- 應用:如將ResNet應用於新醫療場景。

- 操作易度:PyTorch、TensorFlow已整合API。

特徵提取(Feature Extraction)

- 定義:凍結絕大多數層,僅擷取輸出特徵,以SVM等完成分類。

- 適合數據極小或算力有限場景

遷移學習框架比較及推薦

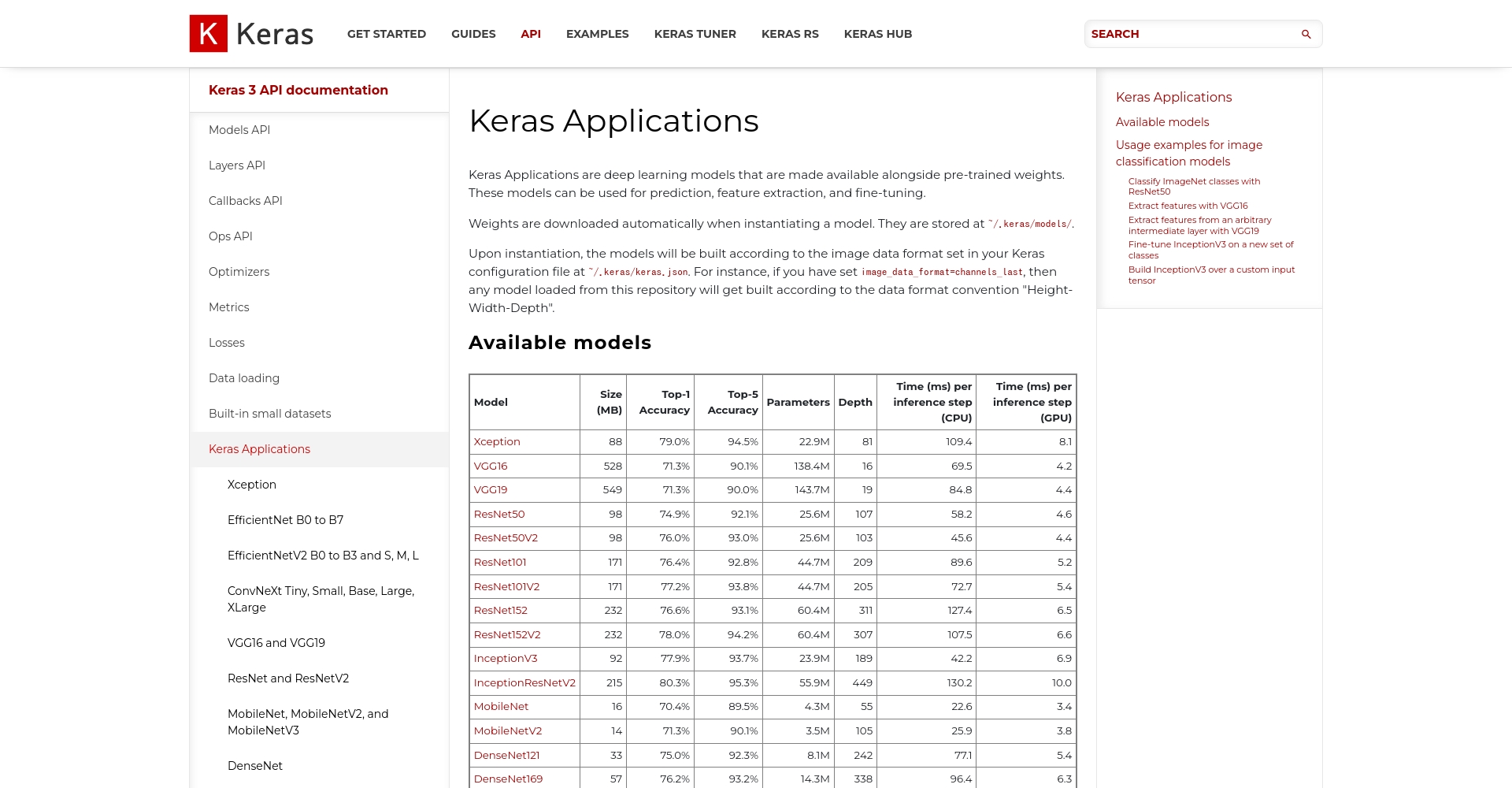

| 模型/平台 | 遷移方式 | 社區成熟度/推薦 | 官方入口 |

|---|---|---|---|

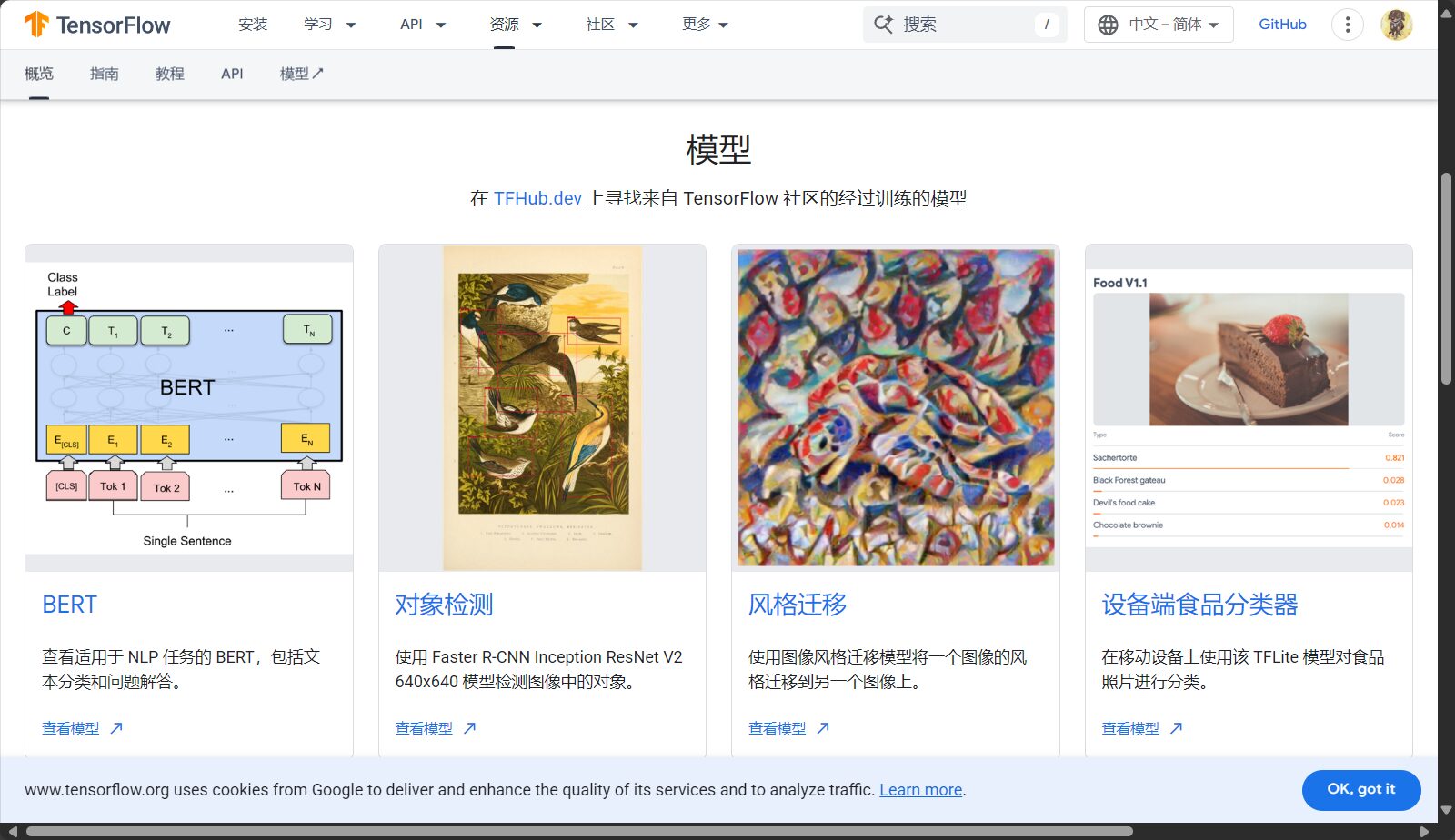

| TensorFlow/Keras | 特徵提取/微調 | API友好、案例多 | 官方教程 |

| PyTorch | 特徵提取/微調 | 適合實驗 | 官方文檔 |

| HuggingFace | 微調NLP | 整合BERT/GPT | 模型庫 |

| Teachable Machine | 視覺化遷移學習 | 全程零碼 | 點擊體驗 |

遷移學習操作流程(新手版全流程)

1. 選擇合適的預訓練模型

- 影像:ResNet、MobileNet、EfficientNet

- NLP:BERT、GPT-2等

- 聲音:VGGish

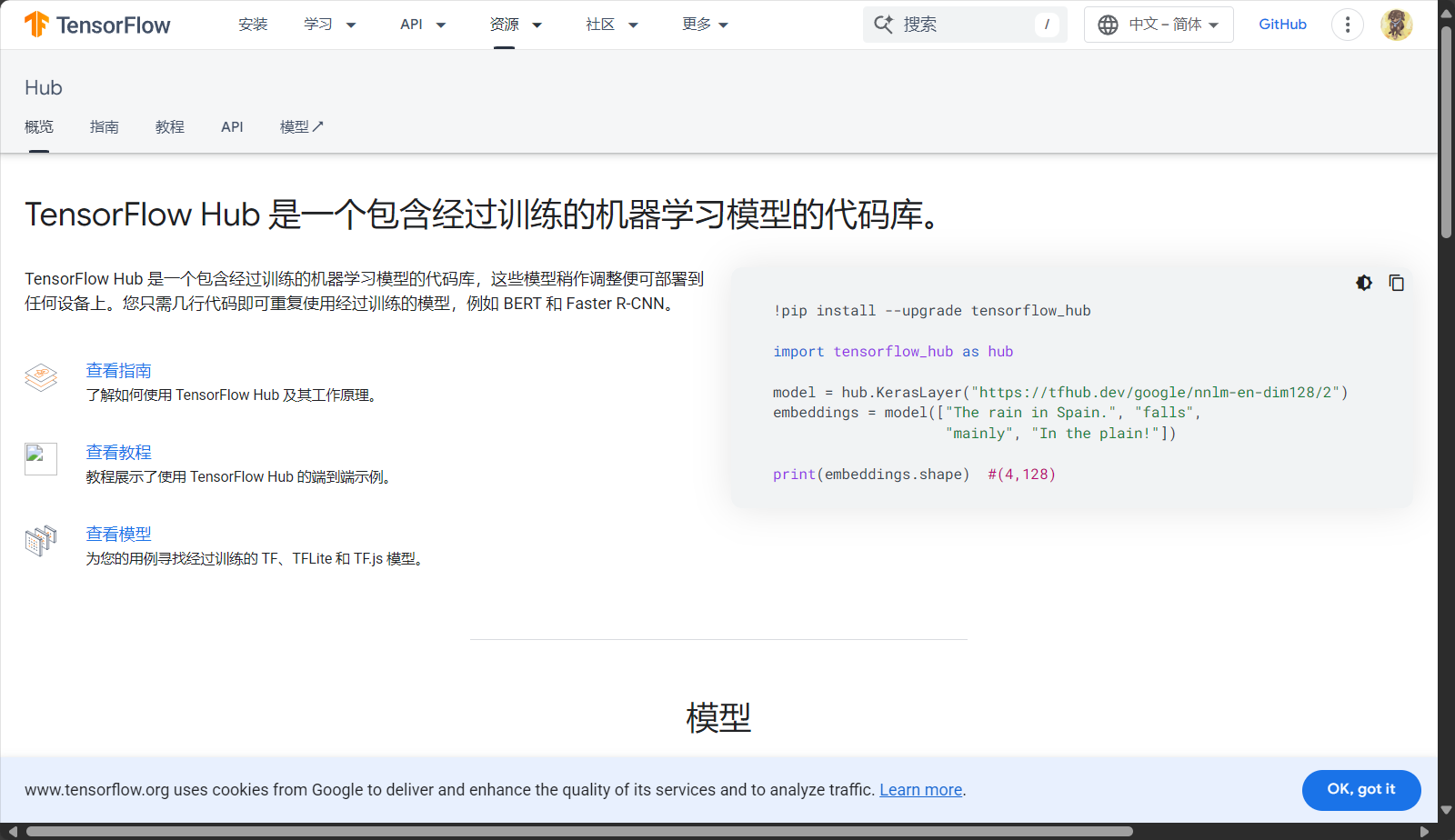

- 公開庫:TensorFlow Hub、Huggingface

2. 準備目標任務小資料集

- 類型與結構最好對標預訓練數據

- 30~200個樣本即可實驗

3. 建構遷移學習流程

- 載入模型,凍結/解凍部分層

- 新加Softmax等輸出層

- 設定學習率、訓練次數

- 訓練與評估

from tensorflow.keras.applications import MobileNetV2 from tensorflow.keras.layers import Dense, GlobalAveragePooling2D from tensorflow.keras.models import Model base_model = MobileNetV2(weights='imageage', include_top_model = MobileNetV2(weights='imagedel', include_top=False) x GlobalAveragePooling2D()(x) predictions = Dense(num_classes, activation='softmax')(x) model = Model(inputs=base_model.input, outputs=predictions) for layer in base_model.layers: layer.trainable loss='categorical_crossentropy', metrics=['accuracy'])

4. 微調並持續最佳化

- 逐步解凍更多層,觀測泛化與精度

- 嘗試不同預訓練模型

- 善用學習率回調、自動調參

優質遷移學習相關AI工具推薦

| 工具名稱 | 支援場景 | 特色 | 難度 | 連結 |

|---|---|---|---|---|

| Teachable Machine | 影像/音訊/姿態 | 網頁化、零代碼 | 極低 | 官網 |

| TensorFlow Hub | 影像/NLP/音訊 | 預訓練模型豐富 | 中等 | 入口 |

| Amazon SageMaker Jumpstart | 影像/NLP/多模態 | 雲端部署、操作簡 | 低 | 介紹 |

| HuggingFace Transformers | NLP為主 | 開源大模型豐富 | 中高 | 模型 |

| Google Colab | 一般 | 免費雲端GPU | 低 | 入口 |

遷移學習實務技巧&常見迷思解讀

新手如何避免踩雷?遷移學習易錯點盤點

- 全凍/全解凍層誤區:全凍模型適應力差,建議逐步解凍並做驗證。

- 忽略輸入資料歸一化:預訓練模型大都有專屬歸一化方式,對錯誤輸入導致效果異常。

- 標籤類別與輸出層數不符:須完全對應。

- 模型太大部署卡頓:終端場景優先選輕量級預訓練模型。

遷移學習新手常見疑問Q&A

| 熱門問題 | 答案要點 |

|---|---|

| 少樣本能用遷移學習嗎? | 適合! 30-100樣本也有優勢 |

| 文字、音訊能遷移嗎? | BERT/wav2vec等皆支持 |

| 哪些任務不適合遷移學習? | 完全無關的異質新任務不適合 |

| 傳統ML能做遷移嗎? | 部分支援如SVM線性特徵遷移 |

遷移學習未來趨勢與高階應用展望

多模態與大模型時代的新機遇

隨著大語言模型(LLM)和多模態模型的普及,遷移學習成為AI標配,支持少樣本微調,協助拓展更多場景。

業界專用的遷移實踐

醫學、農業、金融等領域,利用遷移+大模型思路,用極小樣本建立高可用模型。雲端平台紛紛提供一站式遷移能力。

無論你是AI新手或資深工程師,遷移學習(transfer learning)都在重塑AI開發範式。現在就動手,選一款遷移學習工具,開啟你的自訂AI之路!

© 版權聲明

文章版權歸作者所有,未經允許請勿轉載。

相關文章

暫無評論...