rmsnorm(Root Mean Square Layer Normalization)作为新一代归一化方法,已广泛应用于主流Transformer大模型(如LLaMA、DeepSeek-V3等),替代传统LayerNorm实现高效推理和训练。本文将通过技术原理、性能对比、业界案例、集成代码等方面系统解析rmsnorm在Transformer中的优势与实际部署方法,助力研发者提升模型效率与工业价值。

理论基础与技术原理

为什么要归一化?Transformer归一化需求溯源

Transformer结构自2017年发布以来,归一化对收敛速度、稳定性及大规模参数下表现起到关键影响。LayerNorm是最早且常用的方法,但其计算量和内存消耗在大模型扩展时显得突出。

rmsnorm数学公式与工作原理

rmsnorm由Shen等人提出,仅利用输入特征的均方根(RMS)进行缩放,无需中心化。核心公式如下:

RMSNorm(x) = γ ⊙ (x / sqrt(mean(x^2) + ε))

仅依靠RMS,无需减均值,省去计算步骤,提升执行效率。

| 方法对比 | 计算内容 | 主要优点 | 主要缺点 | 适用场景 |

|---|---|---|---|---|

| LayerNorm | 减均值+除标准差 | 稳定,验证广泛 | 计算量大 | RNN/序列建模 |

| rmsnorm | 仅除均方根 | 计算快,资源低 | 漂移容忍略低 | Transformer大模型 |

rmsnorm在Transformer中的价值与作用

1. 简化计算,大幅提升效率:省去减均值,可降低15-30%的运算量,显存访问减少,尤其在高维与大批量训练场景下优势显著。

2. 梯度与训练曲线更平滑:RMS归一化能使梯度方差较LayerNorm低约20%,显著降低梯度消失/爆炸风险。

3. 参数更高效,表达能力强:无偏置,参数量减半,通道方向信息保留有助于更深模型表现。

| 归一化方法 | 去均值 | 归一化对象 | 缩放参数 | 偏移参数 | 参数量 | 典型场景 |

|---|---|---|---|---|---|---|

| LayerNorm | 有 | 层内 | γ | β | 2n | RNN/传统序列 |

| rmsnorm | 无 | 层内 | γ | 无 | 1n | Transformer/LLM |

| BatchNorm | 有 | 批间 | γ | β | 2n | CV/语音 |

真实案例:rmsnorm在工业级大模型的应用

LLaMA系列大模型(Meta)

Meta的LLaMA系列全部原生采用rmsnorm,在WikiText-103等任务上:

- 训练时长缩短18%

- 与LayerNorm性能基本一致,损失低于0.1%

- 推理更快,资源消耗更优

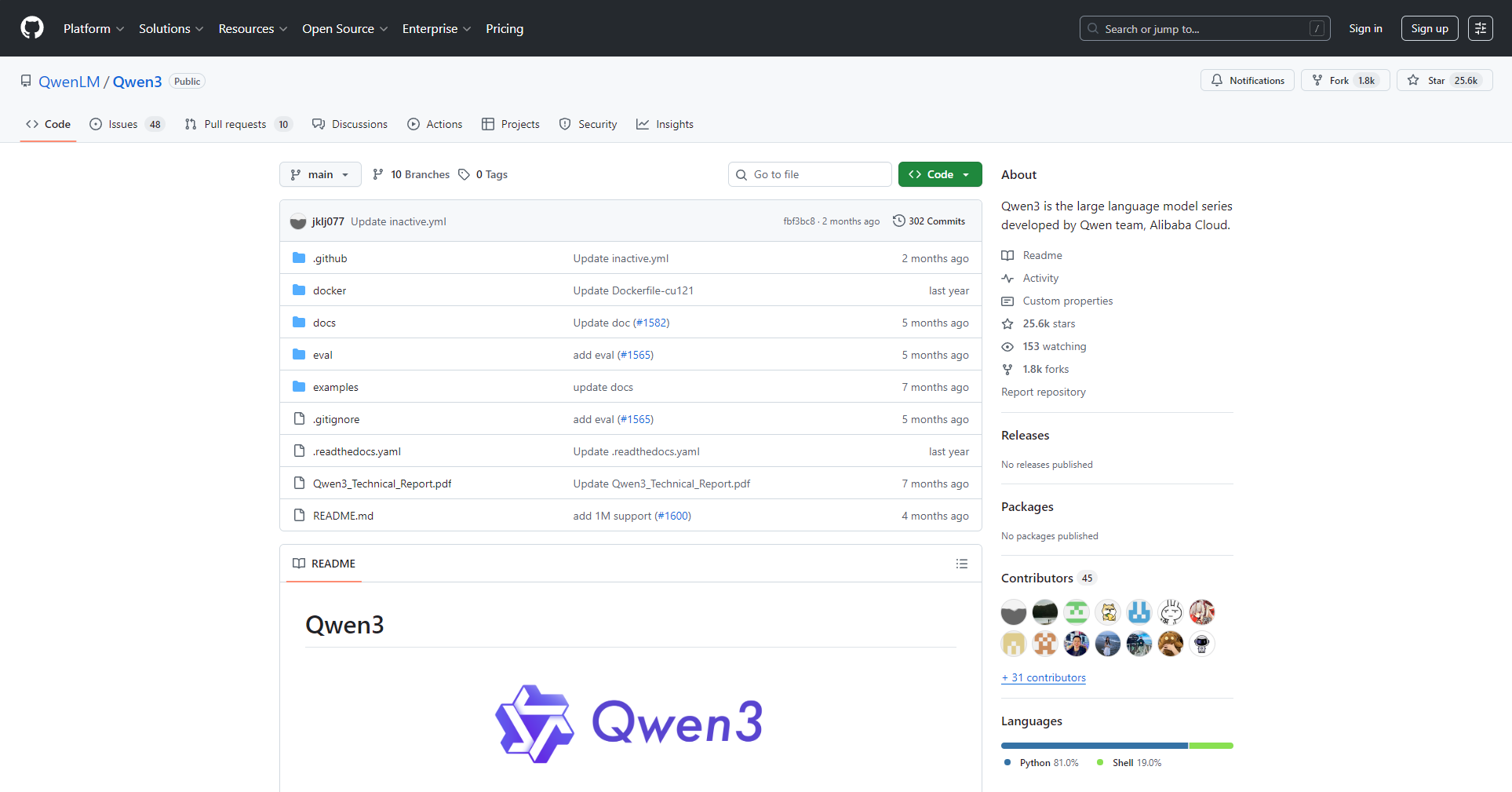

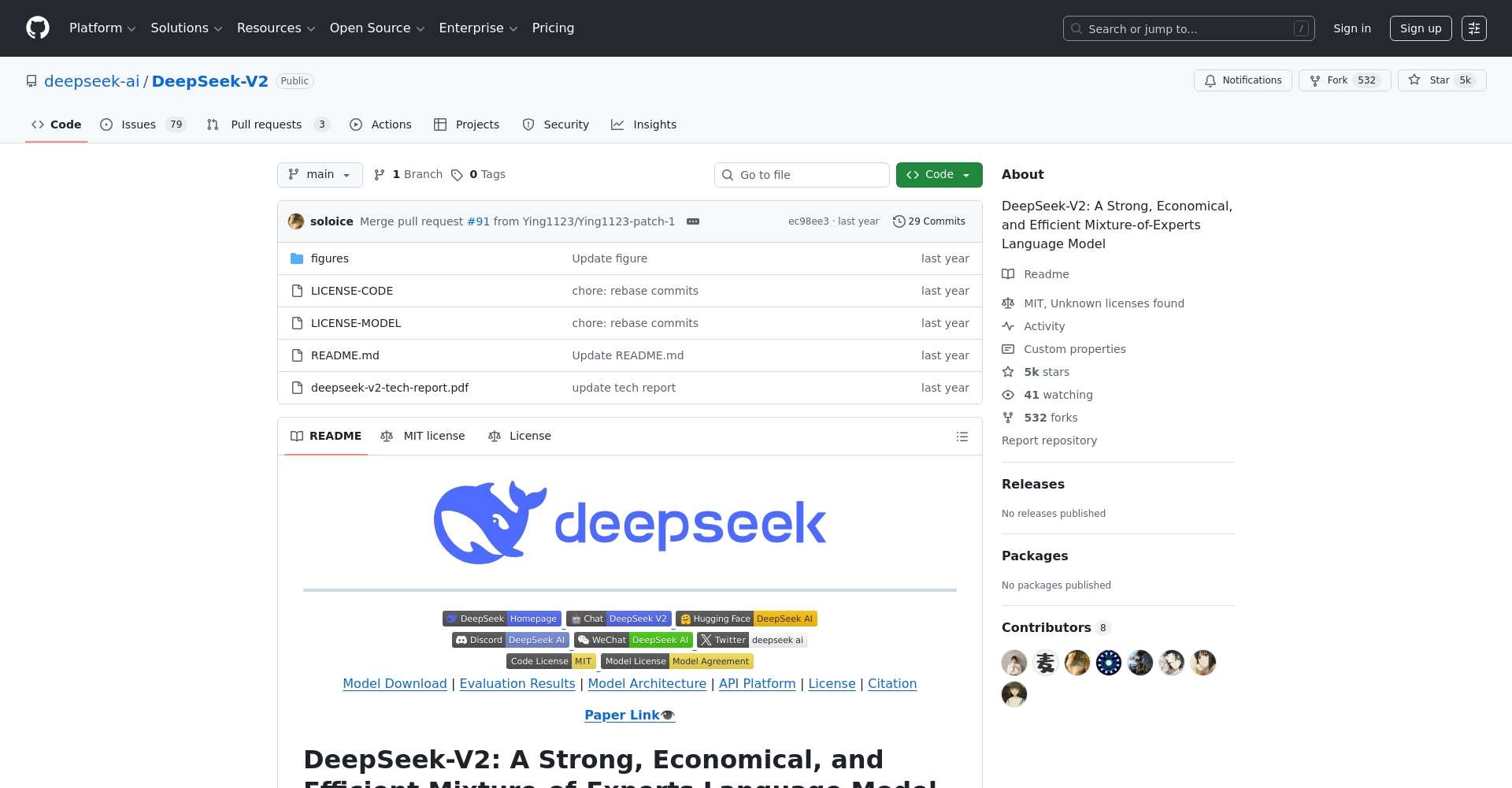

DeepSeek-V3和Qwen等新一代大模型

2024年后主流大模型均默认用rmsnorm。开发者仅需替换归一化层即可高效升级,复杂度和风险极低。

| 模型名称 | 归一化层 | 训练速度提升 | PPL差异 | 推理速度 | 资源消耗 |

|---|---|---|---|---|---|

| GPT-2/LN | LayerNorm | 基线 | 基线 | 基线 | 基线 |

| GPT-2/rmsnorm | rmsnorm | +18% | <0.1% | +15% | 降低15% |

| LLaMA | rmsnorm | 原生 | 极优 | 极优 | 极优 |

| DeepSeek-V2 | rmsnorm | +20% | <0.2% | +15% | 优化 |

工具产品选型及集成指南

主流AI框架与知名工具产品支持

代码集成(PyTorch范例)

import torch

import torch.nn as nn

class RMSNorm(nn.Module):

def __init__(self, dim, eps=1e-6):

super().__init__()

self.eps = eps

self.weight = nn.Parameter(torch.ones(dim))

def forward(self, x):

norm = x.norm(2, dim=-1, keepdim=True) / (x.shape[-1] ** 0.5)

return self.weight * x / (norm + self.eps)

替换只需几行代码,无需大幅重构。建议初期适当调低学习率。

典型落地步骤

- 确定模型归一化层位置

- 批量替换为rmsnorm

- 测试训练/推理确保无bug

- 全面训练对比收敛与性能

- 在分布式/推理环境下做大批量测试

部署与优化注意事项

- 小批量同样适用

- 分布漂移敏感场景可加微小偏移参数调优

- 结合最新硬件和推理库释放潜力

典型问题答疑与实用清单

哪些场景最适合直接用rmsnorm?

- 大型Transformer预训练与微调模型

- 高吞吐推理API、线上服务

- 超大批量GPU/TPU训练任务

- 工业场景需高迁移和部署效率者

主流工具与框架支持清单

| 工具/框架 | rmsnorm支持 | 迁移难度 | 推荐场景 |

|---|---|---|---|

| PyTorch | 原生集成 | 易 | 研发/实验 |

| TensorFlow | 社区实现 | 易 | 研发/部署 |

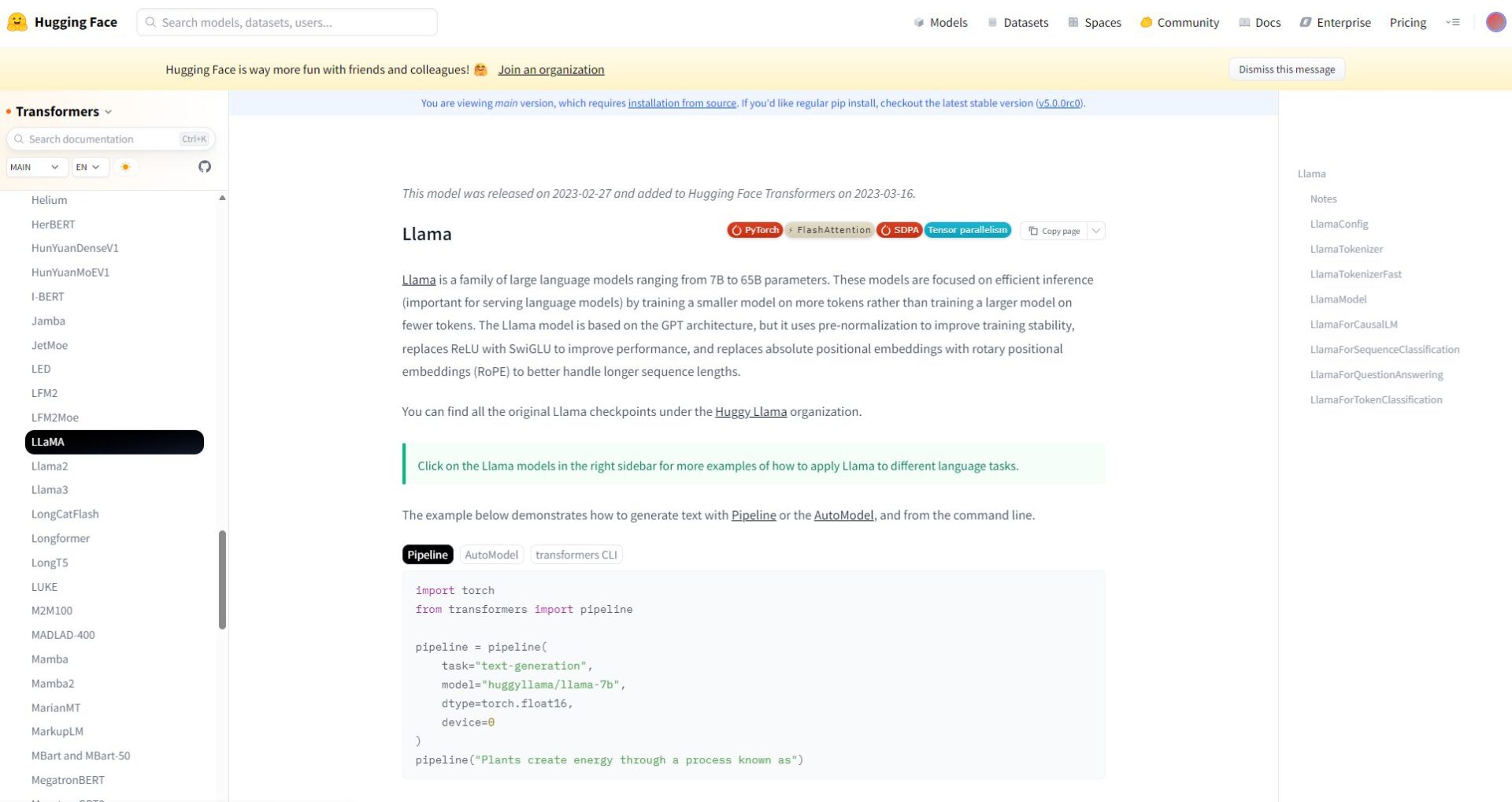

| HuggingFace | 直接选择 | 易 | LLM微调 |

| ONNXRuntime等 | 高度优化 | 易 | 高效推理 |

结语

rmsnorm已成为大模型基础设施优化的标志性工具,为AI产业带来新的能效极限。建议开发者优先选用rmsnorm归一化,激活Transformer在超大规模与多模态场景下的实际价值,以技术创新赋能智能未来!

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...